【详述】使用sr 查询hive外表报错hdfsOpenFile failed

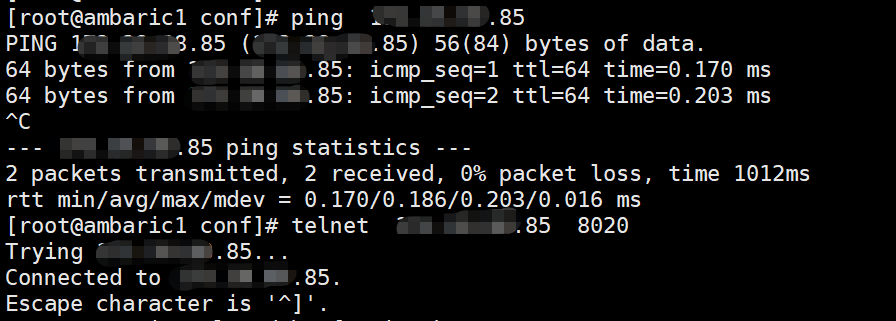

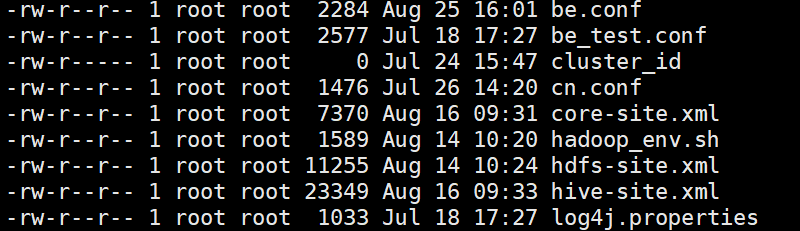

【背景】配置了hdfs-site core-site hive-site hadoop_env 也配置了krb5相关的操作 配置了cron定时刷新 部份表可以查出来数据 部份表不可以

【业务影响】无法鱼hive联席查询

【StarRocks版本】3.0.4

【集群规模】3fe + 3be

【机器信息】36C/128G/千兆

【联系方式】社区群14-伴梦

【附件】

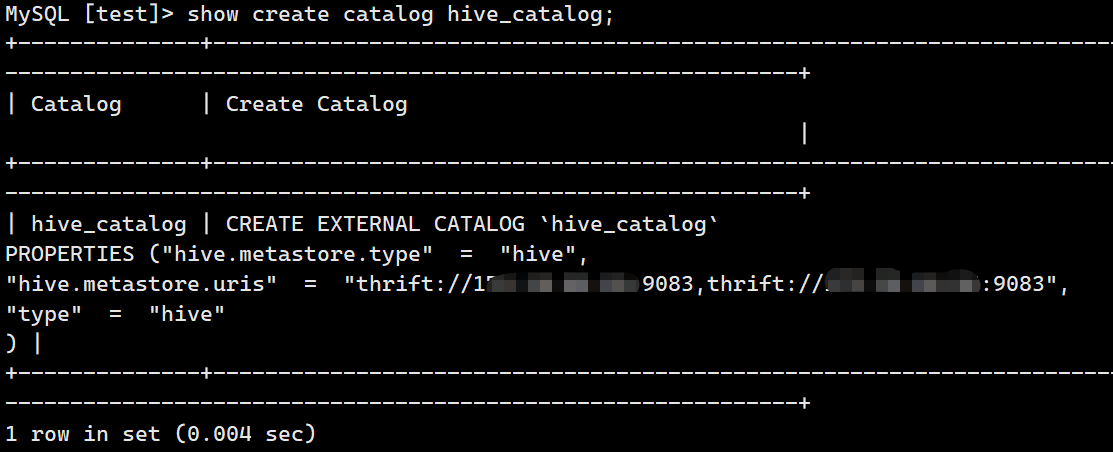

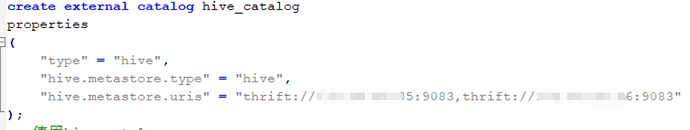

创建catalog语法

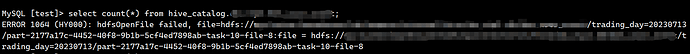

查询报错样例

select count() from hive_catalog.database.table1;

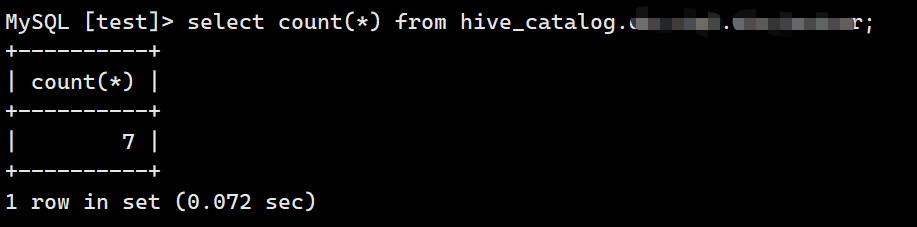

正确查询样例

select count() from hive_catalog.database.table1;