我们现在临时采用了export方式,不太着急,等v2.5.13发布了,我们再升级吧

正在修复,如果急需,可以临时打个Patch

想问下3.1.2中有修复吗?

3.1.2还没有修复,急的话,可以给你打个临时包

1赞

你好,请问这个能给出个3.1版本临时的镜像嘛

3.1的哪个版本?

3.1最新的吧,我看前几天github上出了3.1.3的tag了,缩减了镜像大小,感谢

请问这个修复的包什么时候会打出来- -

你当前用的是哪个版本

现在用的是2.5.8

2.5.13明天或后天就要发了,等下吧

想问下3.1.3包含了这个fix吗?

没有,3.1.4才会修复这个问题

请问3.1.4预计什么时候发布

我们公司有一张超过800GB的表,同步还是报错。

300GB的表是可以正常同步的。

什么版本?可以调下这个: starrocks.exec.mem.limit

3.1.4 已经调整到200GB还是报错。。

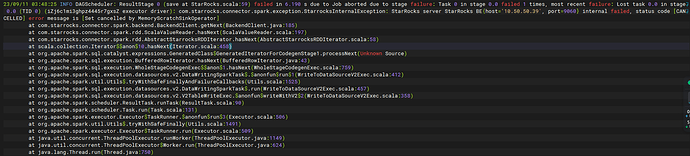

BE对应的报错信息发下