【详述】spark connector 读数据时报错: Set cancelled by MemoryScratchSinkOperator

【背景】

【业务影响】

【StarRocks版本】2.5.6

【集群规模】3fe +5be(fe与be混部)

【机器信息】32C/128G/万兆

【联系方式】StarRocks 社区群 3; 如斯

【附件】

spark connector 端报错

com.starrocks.connector.spark.exception.StarrocksInternalException: StarRocks server StarRocks BE{host='10.65.23.237', port=9060} internal failed, status code [CANCELLED] error message is [Set cancelled by MemoryScratchSinkOperator]

at com.starrocks.connector.spark.backend.BackendClient.getNext(BackendClient.java:192)

at com.starrocks.connector.spark.rdd.ScalaValueReader.hasNext(ScalaValueReader.scala:197)

at com.starrocks.connector.spark.rdd.AbstractStarrocksRDDIterator.hasNext(AbstractStarrocksRDDIterator.scala:58)

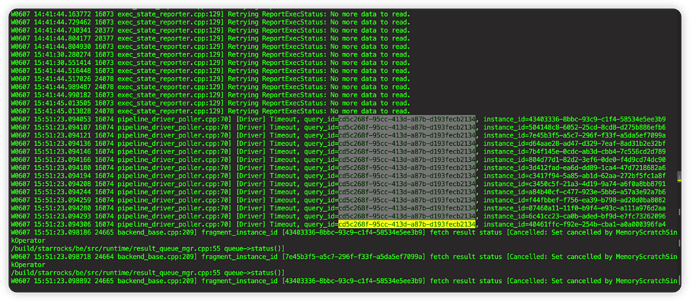

be报错: