【详述】使用flink-connector的stream实时写入数据到sr,有时候会出现http 502报错,现象是同一个任务的同一个流写入两张表,其中一张表有数据,另一张表没有数据的情况

【背景】

【业务影响】

【是否存算分离】存算一体

【StarRocks版本】 3.1.1,使用的k8s-operator部署,operator版本:v1.8.6-rc4

【集群规模】3fe(1 follower+2observer)+5be(fe与be分别部署)

【机器信息】48C/64G/万兆

【联系方式】社群区17-周什么周

【附件】

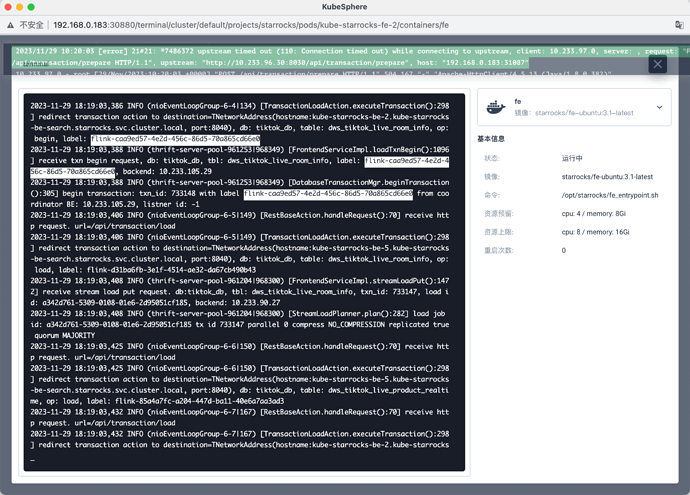

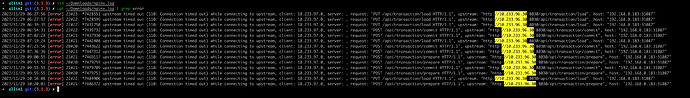

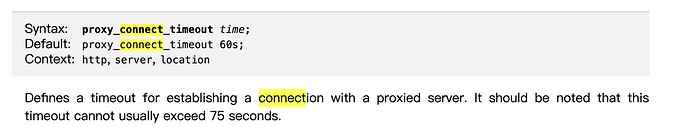

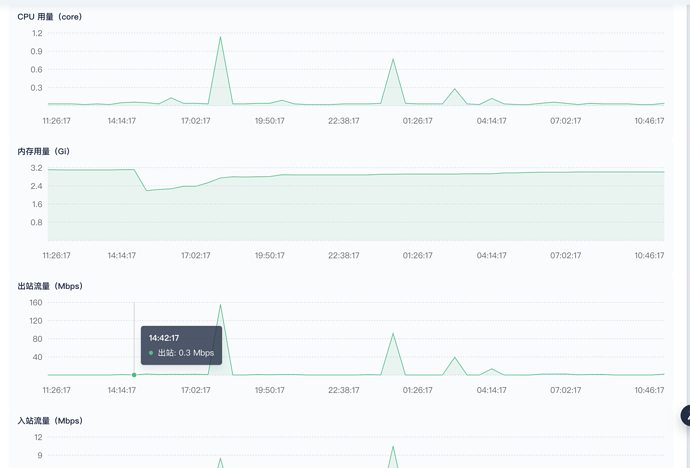

fe-proxy错误截图:

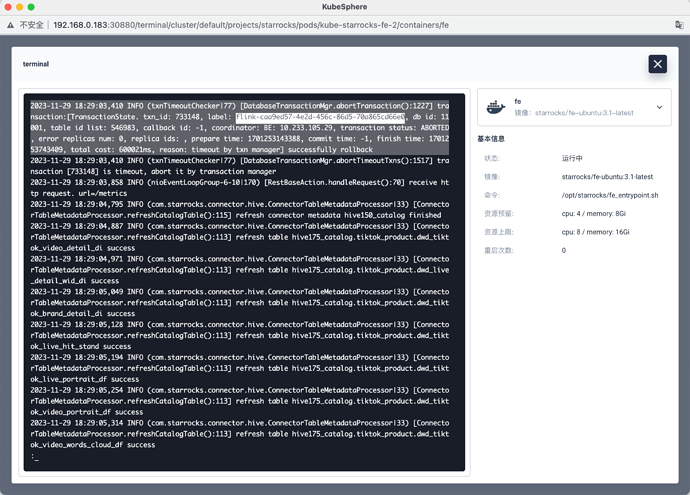

fe错误截图:

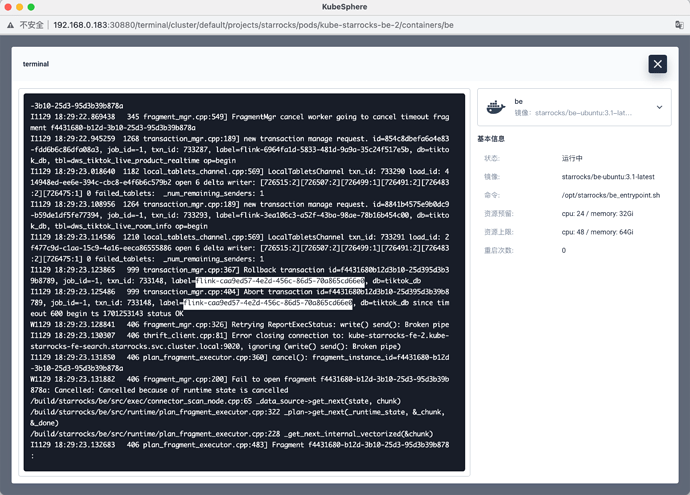

be错误截图:

fe.log.gz (21.6 MB)

be.INFO.gz (49.6 MB)

nginx.log (2.4 MB)