【详述】存算分离模式下flink-cdc导入mysql数据到starrocks报错:

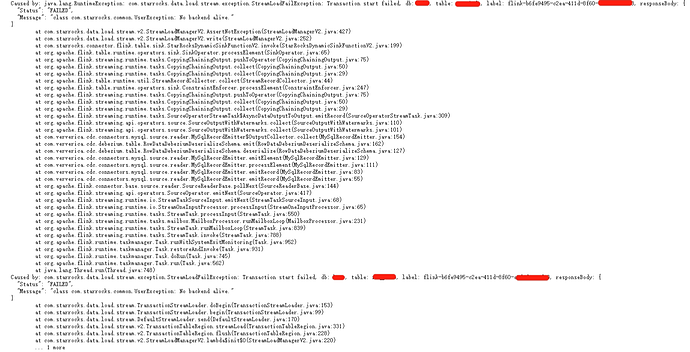

Caused by: com.starrocks.data.load.stream.exception.StreamLoadFailException: Transaction start failed, db: test, table: test, label: flink-b6fe9495-c2ea-411d-8f60-a7d34fc3, responseBody: {

“Status”: “FAILED”,

“Message”: “class com.starrocks.common.UserException: No backend alive.”

}

【背景】通过StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

env.setParallelism(1);

StreamTableEnvironment tableEnv = StreamTableEnvironment.create(env);

tableEnv.executeSql(transformSQL)

将mysql数据同步到starrocks,starrocks部署的是存算分离模式,数据存储在hdfs,已指定了本地缓存目录,通过命令查看fe和cn节点状态都是alive为true,已添加 flink-connector-mysql-cdc.2.4.2.jar 和 flink-connector-starrocks.1.2.8_flink-1.17.jar,打包为flink.jar运行报错No backend alive,请问是因为我部署的starrocks存算分离模式没有be节点吗?存算分离的部署模式无法用flink-cdc同步mysql数据到starrocks?

【业务影响】

【StarRocks版本】例如:3.1.3

【集群规模】例如:3fe(1 follower+2observer)+3cn(fe与cn混部)

【机器信息】CPU虚拟核/内存/网卡,例如:48C/64G/万兆

【表模型】例如:主键模型

【导入或者导出方式】例如:Flink

【联系方式】King.Jin@leekumkeegroup.com,谢谢

【附件】

请问这个issue在哪个版本解决的?升级集群?flink的依赖要升级吗