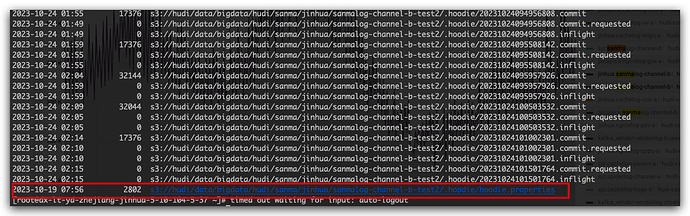

#Properties saved on 2023-10-19T07:56:13.113Z

#Thu Oct 19 15:56:13 CST 2023

hoodie.table.precombine.field=ts

hoodie.datasource.write.drop.partition.columns=false

hoodie.table.partition.fields=dt

hoodie.table.type=COPY_ON_WRITE

hoodie.archivelog.folder=archived

hoodie.table.cdc.enabled=false

hoodie.timeline.layout.version=1

hoodie.table.version=5

hoodie.table.recordkey.fields=ts

hoodie.datasource.write.partitionpath.urlencode=false

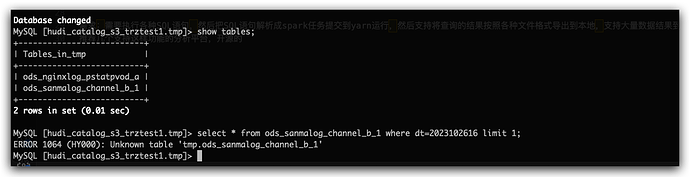

hoodie.table.name=ods_sanmalog_channel_b

hoodie.table.keygenerator.class=org.apache.hudi.keygen.SimpleAvroKeyGenerator

hoodie.datasource.write.hive_style_partitioning=true

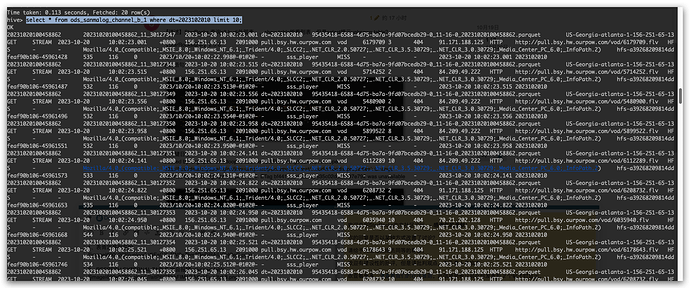

hoodie.table.create.schema={“type”:“record”,“name”:“ods_sanmalog_channel_b_record”,“namespace”:“hoodie.ods_sanmalog_channel_b”,“fields”:[{“name”:“host”,“type”:[“null”,“string”],“default”:null},{“name”:“event”,“type”:[“null”,“string”],“default”:null},{“name”:“category”,“type”:[“null”,“string”],“default”:null},{“name”:“date”,“type”:[“null”,“string”],“default”:null},{“name”:“time”,“type”:[“null”,“string”],“default”:null},{“name”:“time_zone”,“type”:[“null”,“string”],“default”:null},{“name”:“s_ip”,“type”:[“null”,“string”],“default”:null},{“name”:“pid”,“type”:[“null”,“string”],“default”:null},{“name”:“vhost”,“type”:[“null”,“string”],“default”:null},{“name”:“app”,“type”:[“null”,“string”],“default”:null},{“name”:“app_inst”,“type”:[“null”,“string”],“default”:null},{“name”:“duration”,“type”:[“null”,“long”],“default”:null},{“name”:“status”,“type”:[“null”,“int”],“default”:null},{“name”:“c_ip”,“type”:[“null”,“string”],“default”:null},{“name”:“protocol”,“type”:[“null”,“string”],“default”:null},{“name”:“uri”,“type”:[“null”,“string”],“default”:null},{“name”:“uri_stem”,“type”:[“null”,“string”],“default”:null},{“name”:“uri_query”,“type”:[“null”,“string”],“default”:null},{“name”:“referer”,“type”:[“null”,“string”],“default”:null},{“name”:“user_agent”,“type”:[“null”,“string”],“default”:null},{“name”:“client_id”,“type”:[“null”,“string”],“default”:null},{“name”:“bytes_received”,“type”:[“null”,“long”],“default”:null},{“name”:“bytes_send”,“type”:[“null”,“long”],“default”:null},{“name”:“file_size”,“type”:[“null”,“string”],“default”:null},{“name”:“request_info”,“type”:[“null”,“string”],“default”:null},{“name”:“cli_name”,“type”:[“null”,“string”],“default”:null},{“name”:“x_comment”,“type”:[“null”,“string”],“default”:null},{“name”:“x_result”,“type”:[“null”,“string”],“default”:null},{“name”:“tmp1”,“type”:[“null”,“string”],“default”:null},{“name”:“tmp2”,“type”:[“null”,“string”],“default”:null},{“name”:“ext”,“type”:[“null”,“string”],“default”:null},{“name”:“ts”,“type”:[“null”,“string”],“default”:null},{“name”:“dt”,“type”:[“null”,“string”],“default”:null}]}

hoodie.table.checksum=496443571