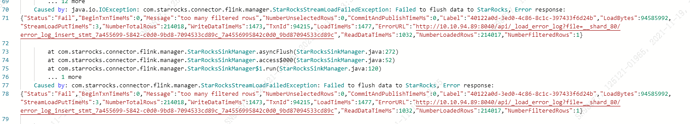

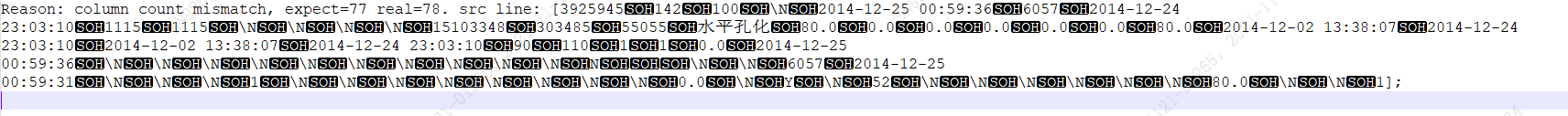

【详述】使用flink-connect 导入数据,starrock字段与源端字段数量一致,但是执行一段时间后会报错

会在原本的字段后面多出一个字段 如图中是 新增了一个字段 “1”

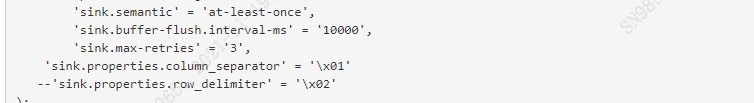

flink任务配置

【导入/导出方式】flink-connect

【StarRocks版本】例如:1.19.1

【集群规模】例如:3fe(1 follower+2observer)+7be(fe与be混部)

【机器信息】CPU虚拟核/内存/网卡,例如:48C/64G/万兆

【附件】

- fe.warn.log/be.warn.log/相应截图