为了更快的定位您的问题,请提供以下信息,谢谢

【详述】问题详细描述:

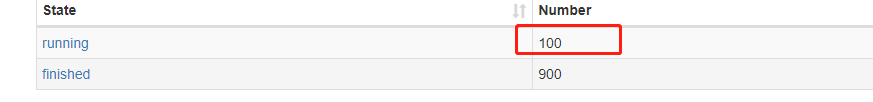

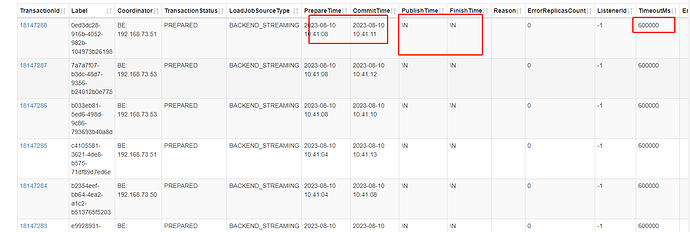

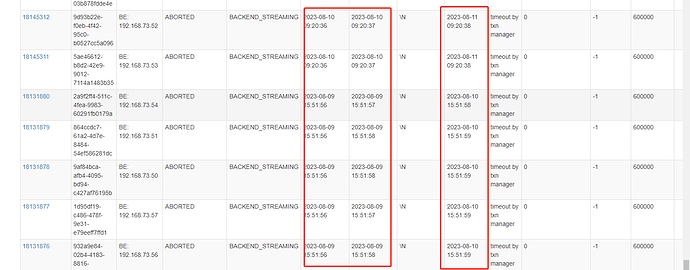

使用社区提供的flink connecter导入数据到starrocks,采用exactly once模式,64个并发,30s一个checkpoint写入数据,遇到了如果64个并行度中如果有1个并行度出现fail的情况,就会导致占用的事务数变成了65个,并且多出来的这个事务要24小时后才会关闭。假如整个ck做失败,就会导致多占用64个事务,同样的也是24小时后才会关闭多占用的事务,由于无法对单库开太多的事务数,所以会导致任务一直失败,事务直接顶满的状态,直至24小时以后才会放开,并且24小时内无法写入任何数据。

【背景】flink消费kafka数据进行jason解析写入json格式的文件到starrocks

【业务影响】

【StarRocks版本】2.5.4

【集群规模】3fe(3 follower)+5be(fe与be混部)

【机器信息】CPU虚拟核/内存/网卡,64C/256G/万兆

【表模型】明细模型

【导入或者导出方式】Flink

【联系方式】richard.wu@51job.com

【附件】

目前还在占用的事务数:

事务所开启时间为8月10日十点直到8月11日九点多仍未关闭

观察历史失败任务的事务关闭时间周期为24小时,并且页面线上的timeout时间并未生效