为了更快的定位您的问题,请提供以下信息,谢谢

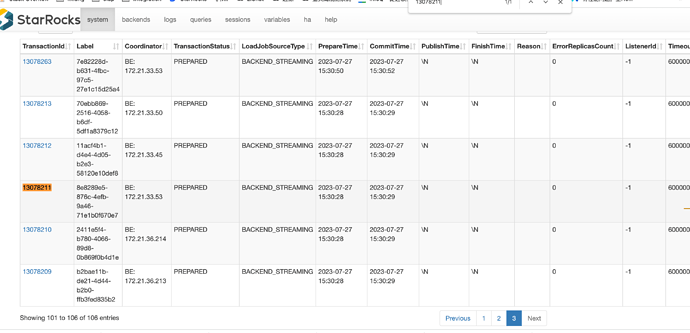

【详述】15:30 开始突然同一个库下的导入任务都卡住处于 prepare 状态,看日志 commit 后卡住了,请问下原因是什么?

【背景】没做操作

【业务影响】

【StarRocks版本】2.5.4

【集群规模】例如:3fe+5be(fe与be独立部署)

【机器信息】CPU虚拟核/内存/网卡,例如:48C/64G/万兆

【表模型】例如:主键模型

【导入或者导出方式】Flink 导入

【联系方式】18829283520

【附件】

一共有 100 个同一个库的事务卡住,从 15:30 开始

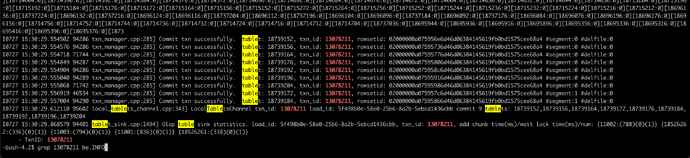

以 transactionId = 为例,查看对应 be cooridinotr 的日志,commit 后一直卡住了