【详述】表查询中存在大字段会报错内存不够用,请问该如何处理

【背景】有一张表在执行insert overwrite select的时候经常出现Mem usage has exceed the limit of BE或者be节点oom,奇怪的是有时候它会执行成功。发现这张表其实数据量6百万条并不大,但是存在一个大字段varchar(70000)。当把这个字段从查询中删除后,语句执行非常稳定,不再出现问题。请帮我解释下问题原因,并请教下如何处理这种情况,可以接受执行慢一点,但想要执行稳定不报错。

【业务影响】

【StarRocks版本】2.5.3

【集群规模】例如:3fe+3be(fe与独立部)

【机器信息】fe:8C/32G be:16C/32G

【联系方式】社区群14-相,谢谢

【附件】

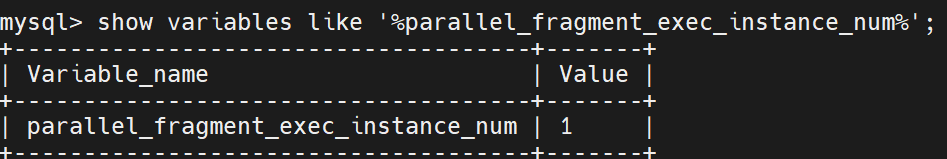

- 并行度:show variables like ‘%parallel_fragment_exec_instance_num%’;

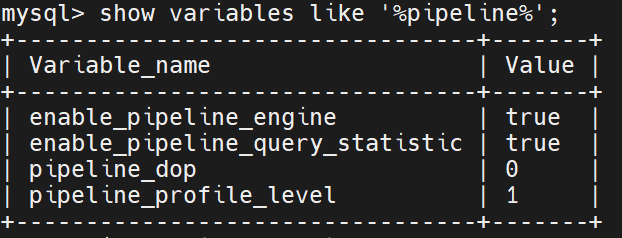

- pipeline是否开启:show variables like ‘%pipeline%’;