这个是超时导致的,超时时间配置的是多少?

starrocks.request.query.timeout.s

query_timeout 36000

大概跑了4小时就报错了,上面这个是starrocks配置, 你发的这个是spark的配置吗?

是的,Spark任务的配置

我的版本是 2.5.13 , 也遇到了同样的问题, 2.5.13 不是已经修复了吗

列多的话,调大这个试试: starrocks.exec.mem.limit

1赞

大佬,我们sr 3.1.17 怎么还有这个问题,表 单分区 8个tablet ,starrocks.request.tablet.size=1,开了8个task 读取任务,6个成功了,2个失败了, 表只有两列,但是一个列是json 字符串很大。

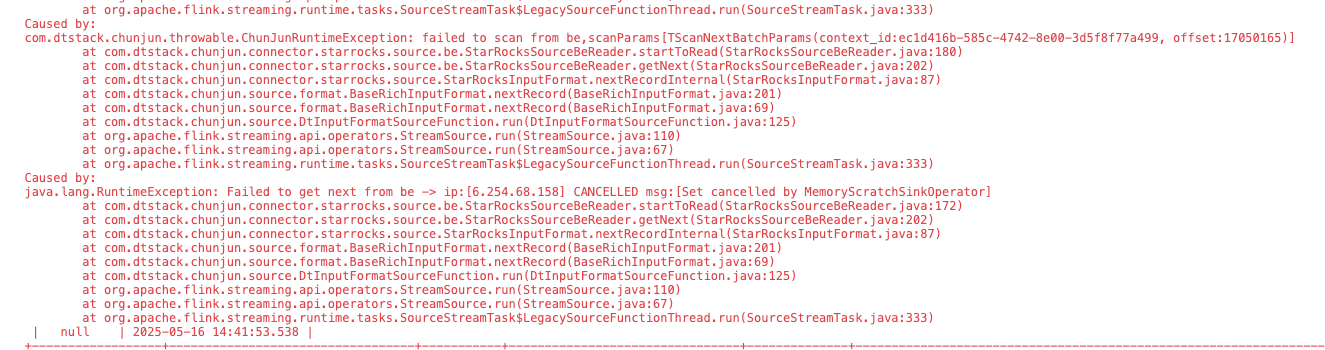

internal failed, status code [CANCELLED] error message is [Set cancelled by MemoryScratchSinkOperator]

去BE日志里看看是什么原因导致失败的。starrocks.request.tablet.size用默认值就行

大佬好,我使用flinkx中的starrocks的connector来读取starrocks中的数据,starrocks用的版本:3.3.5 ,flink的版本是1.17.2,数据量:5亿条左右,任务在执行1小时左右也报了如下异常:

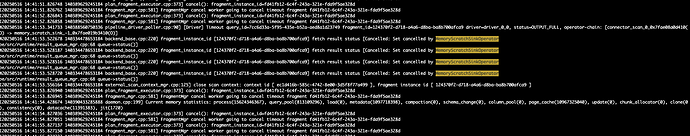

be中的报错如下:

大佬帮忙给看看看

有解决思路吗,我们也遇到这个问题,数据量13亿条,flink版本1.18.1,starrocks版本:3.3.12

搜id看原因

看BE的日志