【详述】多个streamload任务写入同表同分区发现耗时较久

【背景】只有704条数据,500K左右

【业务影响】

【StarRocks版本】2.3.3

【集群规模】3fe(2 follower+1observer)+6be(fe与be混部)

【机器信息】108C/500G/万兆

【联系方式】社区群1-invert或者532309747@qq.com

【附件】

701条数据 总耗时单位是秒吗

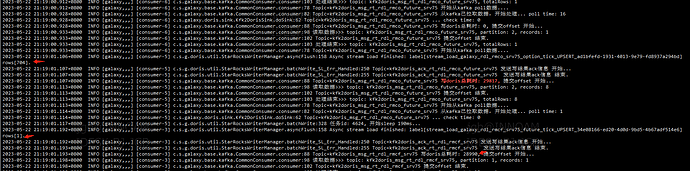

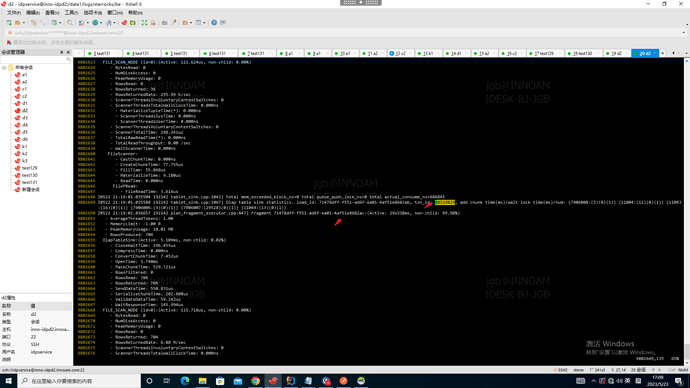

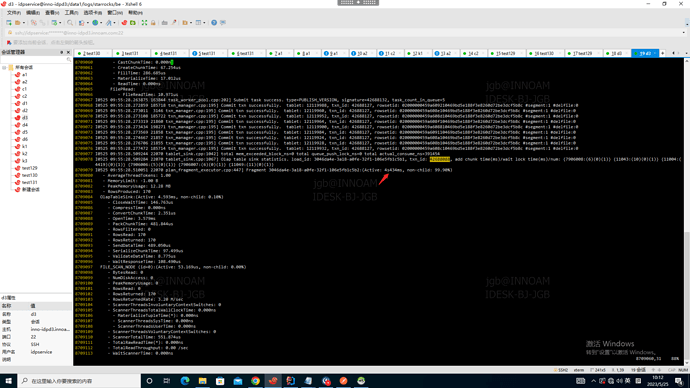

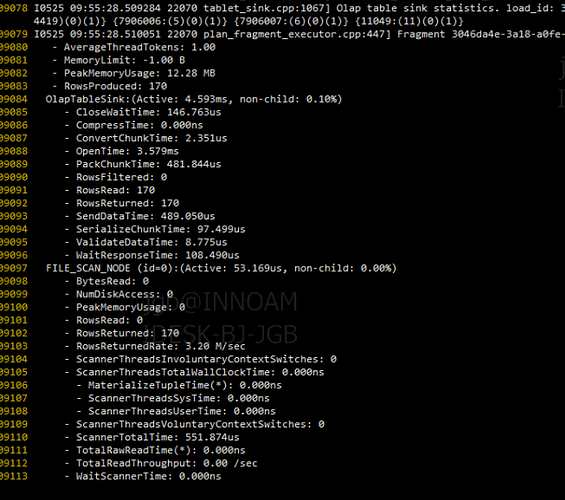

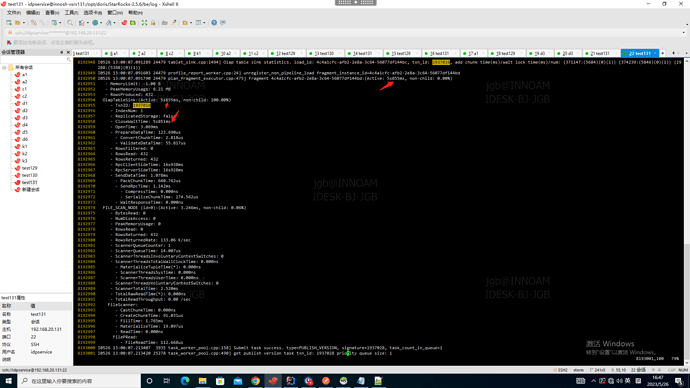

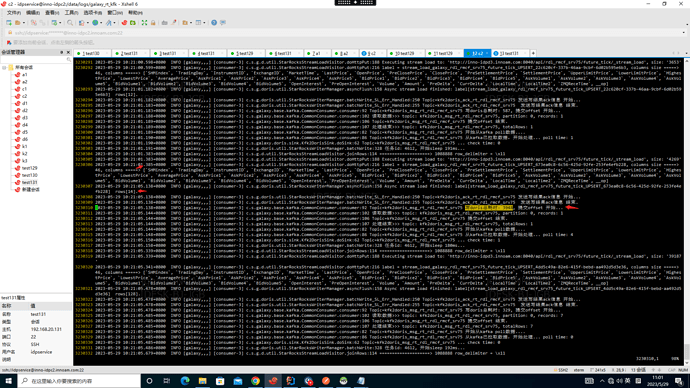

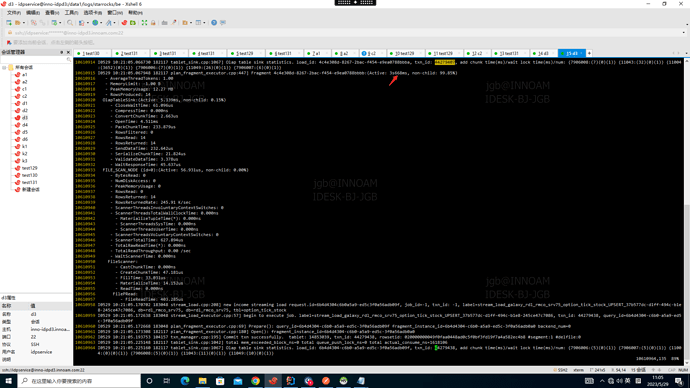

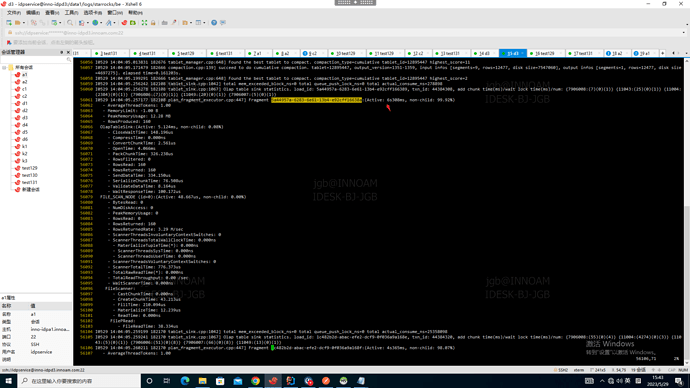

是的,耗时29s多,查be日志 耗时如图

如果stream load不是写入同表同分区 就不慢了吗?

您每批任务跑多点数据,几十万,几百万都可以的。每批操作的数据量太少了。

麻烦问下能微信聊吗,这个太慢,我们要验证 秒级实时写入,不能超过2s;

日志后面没有了,只是看到耗时大,不清楚那个地方导致的?

实时写入用flink吧

flink 和 streamload 区别?

flink可以做到2秒内,stream load主要是用来做批量导入,不是用来做实时写入的。

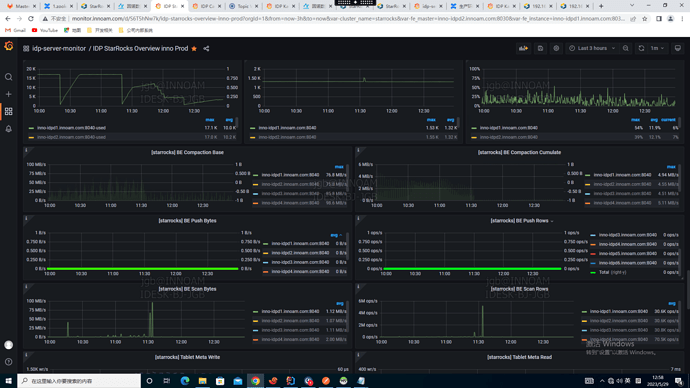

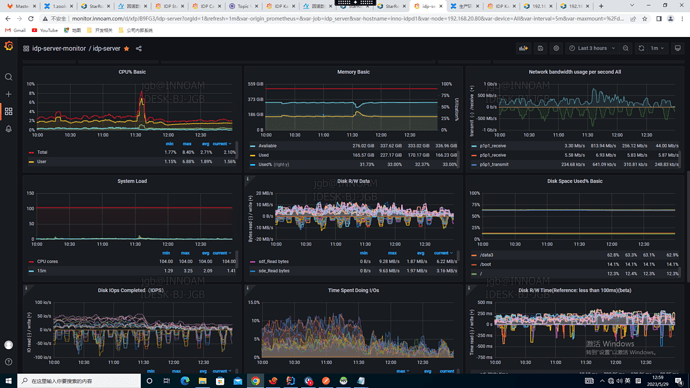

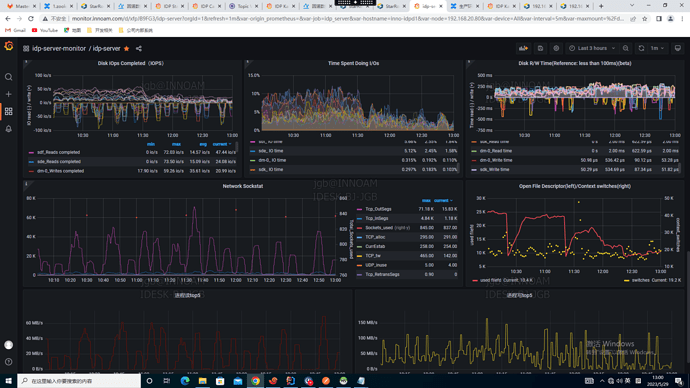

卡在刷盘了,是不是磁盘性能比较差,磁盘IO很高

BE参数 flush_thread_num_per_store=8 调整一下吧

ok ,我们试试