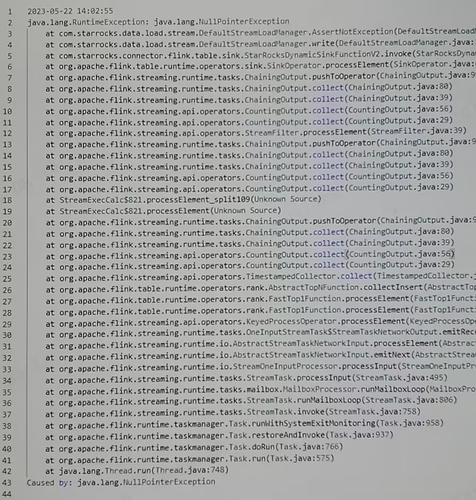

【详述】1.2.5版本flinksql-connector写入2.5.1版本starrocks存在空指针异常报错

【背景】将原始数据写入starrocks的ods层

【业务影响】

【StarRocks版本】2.5.1

【集群规模】3fe+3be;均单独配置

【机器信息】48C/64G/万兆

【表模型】主键模型

【导入或者导出方式】Flink

【联系方式】:社区群17-Z.;邮箱:endeeper@126.com

【附件】

-

数据均写入成功,不存在丢数和失败的情形,但是会出现上述报错,而且最近非常频繁

收到 我们确认一下 2.5.1和flink 1.2.5版本是否适配

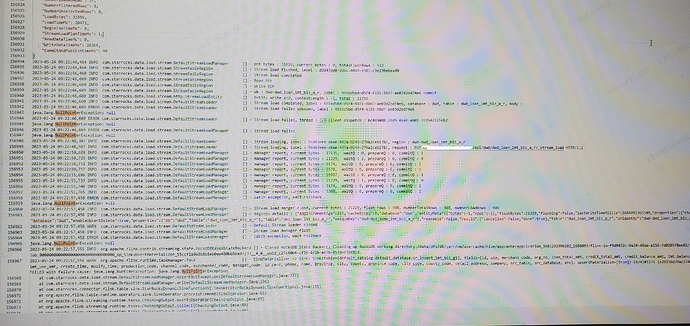

方便发一下报错的taskmanager日志吗

感谢,最近真的是疯狂因为那个原因报错,导致任务间隔很短时间就会失败

之前是没有这个报错的,但是最近这个报错五分钟就有一次,然后所有实时任务全部重启

At-least-once导入频率受以下3个参数限制

sink.buffer-flush.max-bytes // 默认值是94371840(90M),the max batching size of the serialized data, range: [64MB, 10GB] .

sink.buffer-flush.max-rows // 默认值是500000,the max batching rows, range: [64,000, 5000,000] .

sink.buffer-flush.interval-ms // 默认值是300000,the flushing time interval, range: [1000 ms , 3600000ms] .

exactly-once语义时,设置的sink.buffer-flush.{max-rows|max-bytes|interval-ms}属性将会变成无效。

将使用checkpoint interval设置的值。

调一下 频率不要这么高 攒批

我有的任务攒批是30s的也是一样一直报错,我觉得应该和批次大小、频繁导入无关

而且之前开2s攒批写入也没遇到过这个问题

现在不管是哪种攒批方案都在疯狂报错nullpoint,几乎是所有的flink写入starrocks任务

甚至存在刚刚启动的任务会因为上述报错直接失败重试!

方便发一下报错的taskmanager日志吗

上面有啊,不过只能拍照

最终发现是fe节点频繁oom的原因,之前三台fe都是8G内存,现在已经全部升级到16G,问题已经解决了。