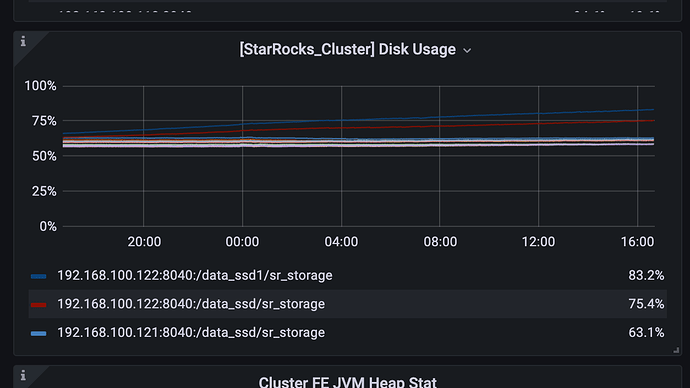

BE该问题一直出现。。。

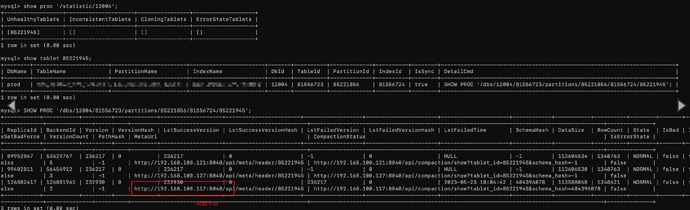

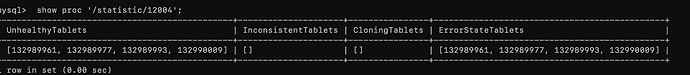

mysql> show proc '/statistic/108138199';

+------------------+---------------------+----------------+-------------------+

| UnhealthyTablets | InconsistentTablets | CloningTablets | ErrorStateTablets |

+------------------+---------------------+----------------+-------------------+

| [108214752] | [] | [] | [108214752] |

+------------------+---------------------+----------------+-------------------+

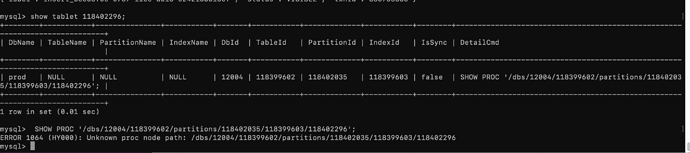

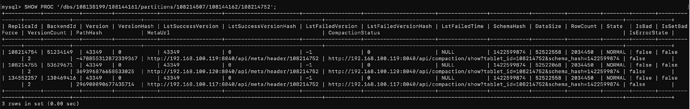

mysql> SHOW PROC '/dbs/108138199/108144161/partitions/108214507/108144162/108214752';

+-----------+-----------+---------+-------------+-------------------+-----------------------+------------------+----------------------+---------------------+------------+----------+----------+--------+-------+---------------+--------------+---------------------+-------------------------------------------------------+--------------------------------------------------------------------------------------------+--------------+

| ReplicaId | BackendId | Version | VersionHash | LstSuccessVersion | LstSuccessVersionHash | LstFailedVersion | LstFailedVersionHash | LstFailedTime | SchemaHash | DataSize | RowCount | State | IsBad | IsSetBadForce | VersionCount | PathHash | MetaUrl | CompactionStatus | IsErrorState |

+-----------+-----------+---------+-------------+-------------------+-----------------------+------------------+----------------------+---------------------+------------+----------+----------+--------+-------+---------------+--------------+---------------------+-------------------------------------------------------+--------------------------------------------------------------------------------------------+--------------+

| 108214753 | 51233777 | 42761 | 0 | 42761 | 0 | 43318 | 0 | 2023-06-25 02:01:51 | 1422599874 | 52428386 | 2031278 | NORMAL | false | false | 2 | 3975779082933983685 | http://192.168.100.118:8040/api/meta/header/108214752 | http://192.168.100.118:8040/api/compaction/show?tablet_id=108214752&schema_hash=1422599874 | true |

| 108214754 | 51234149 | 43318 | 0 | 43318 | 0 | -1 | 0 | NULL | 1422599874 | 52519556 | 2034273 | NORMAL | false | false | 2 | -478855312872339367 | http://192.168.100.119:8040/api/meta/header/108214752 | http://192.168.100.119:8040/api/compaction/show?tablet_id=108214752&schema_hash=1422599874 | false |

| 108214755 | 53629671 | 43318 | 0 | 43318 | 0 | -1 | 0 | NULL | 1422599874 | 52519599 | 2034273 | NORMAL | false | false | 3 | 369396876658533025 | http://192.168.100.120:8040/api/meta/header/108214752 | http://192.168.100.120:8040/api/compaction/show?tablet_id=108214752&schema_hash=1422599874 | false |

+-----------+-----------+---------+-------------+-------------------+-----------------------+------------------+----------------------+---------------------+------------+----------+----------+--------+-------+---------------+--------------+---------------------+-------------------------------------------------------+--------------------------------------------------------------------------------------------+--------------+

3 rows in set (0.00 sec)

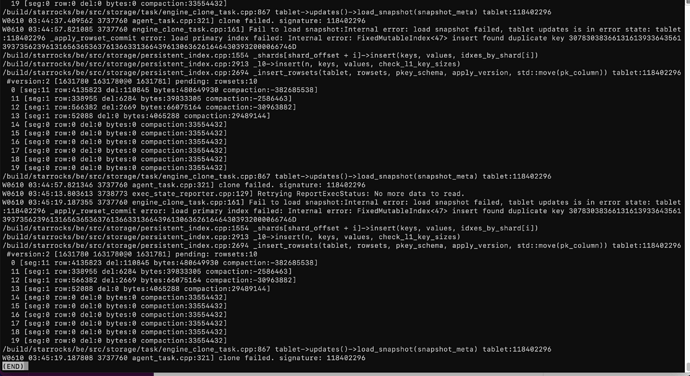

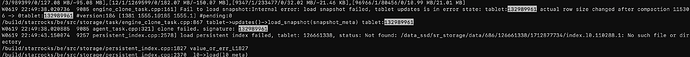

BE.WARING:

/build/starrocks/be/src/storage/task/engine_clone_task.cpp:867 tablet->updates()->load_snapshot(snapshot_meta) tablet:108214752

W0623 03:35:01.576339 133077 agent_task.cpp:321] clone failed. signature: 108214752

W0623 03:35:07.889549 133161 load_channel.cpp:97] Fail to open index 108144162 of load cd4705e566b89e1b-7b97e1f64edf63bb: Service unavailable: Tablet is in error state, tablet_id: 108214752 primary index commit failed: Internal error: duplicate key found in l1 index

/build/starrocks/be/src/storage/persistent_index.cpp:3478 merge_shard_kvs(key_size, l0_kvs_by_shard[shard_idx], l1_kvs, estimate_size_per_shard, kvs)

/build/starrocks/be/src/storage/persistent_index.cpp:3508 _merge_compaction_internal(writer.get(), 0, _l1_vec.size(), _usage_and_size_by_key_length, false)

/build/starrocks/be/src/storage/persistent_index.cpp:2747 _merge_compaction()

/build/starrocks/be/src/storage/delta_writer.cpp:26 writer->_init()

/build/starrocks/be/src/runtime/local_tablets_channel.cpp:70 _open_all_writers(params)

W0623 03:35:21.859416 133076 engine_clone_task.cpp:161] Fail to load snapshot:Internal error: load snapshot failed, tablet updates is in error state: tablet:108214752 primary index commit failed: Internal error: duplicate key found in l1 index

/build/starrocks/be/src/storage/persistent_index.cpp:3478 merge_shard_kvs(key_size, l0_kvs_by_shard[shard_idx], l1_kvs, estimate_size_per_shard, kvs)

/build/starrocks/be/src/storage/persistent_index.cpp:3508 _merge_compaction_internal(writer.get(), 0, _l1_vec.size(), _usage_and_size_by_key_length, false)

/build/starrocks/be/src/storage/persistent_index.cpp:2747 _merge_compaction()

/build/starrocks/be/src/storage/task/engine_clone_task.cpp:867 tablet->updates()->load_snapshot(snapshot_meta) tablet:108214752

W0623 03:35:21.859488 133076 agent_task.cpp:321] clone failed. signature: 108214752