【详述】kafka导入途中be异常退出

【背景】创建routine load导入kafka数据

【业务影响】

【StarRocks版本】2.5.1

【集群规模】例如:1fe +2be(其中一台与fe混部)

【机器信息】16Core 64GB

【附件】

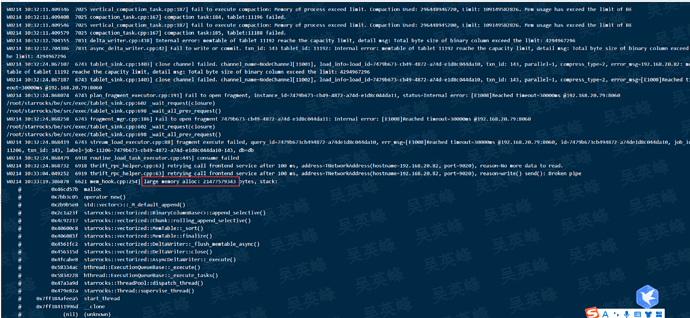

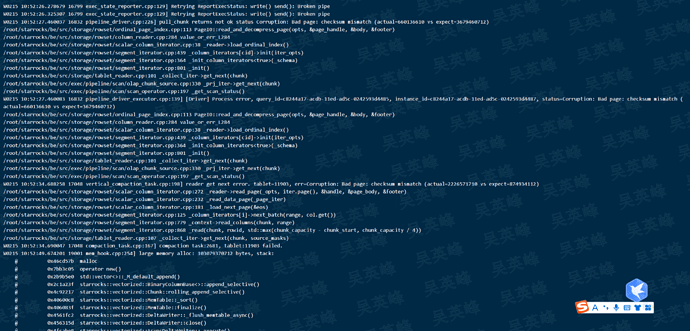

当时每个be节点的数据负载在12g左右,看日志是突然申请了个几十g的内存空间,失败导致be崩溃的,重启后导入任务正常运行。

您sr中的表是什么模型?

都是普通的key,没有指标列,表中共10个INT和20个STRING类型,用于测试

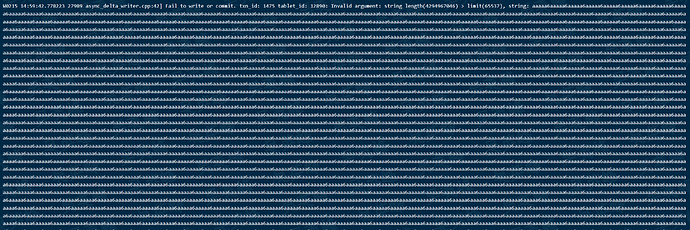

我估计是Starrocks在海量数据导入时,对数据拼接出现了bug,如图starrock将正常的数据读取成了一个超长的字符串,我通过从kafka中消费starrocks故障时的消息偏移的消息可以看到,kafka中的消息内容是正常的,应该是starrocks处理的问题,导致starrcoks读取到了一个超长的字符串,申请了过大的空间导致崩溃。

这也解释了为什么重启be后,导入任务可以正常执行,并且没有丢失任何一行导入的数据(说明崩溃重启后再次消费到的消息格式是正常的,非kafka中存储的消息内容有误)

这个问题可以在特定数据集或者特定的表上稳定复现吗?还是随机出现的?