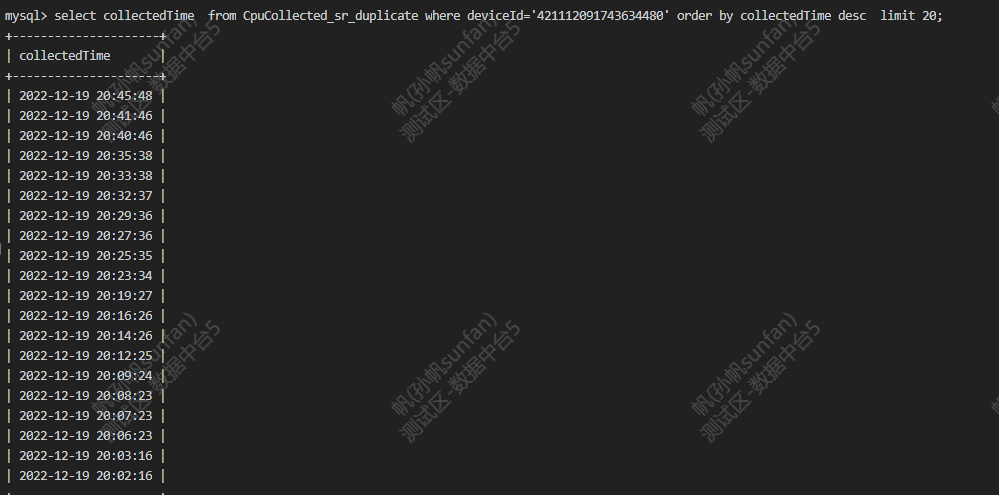

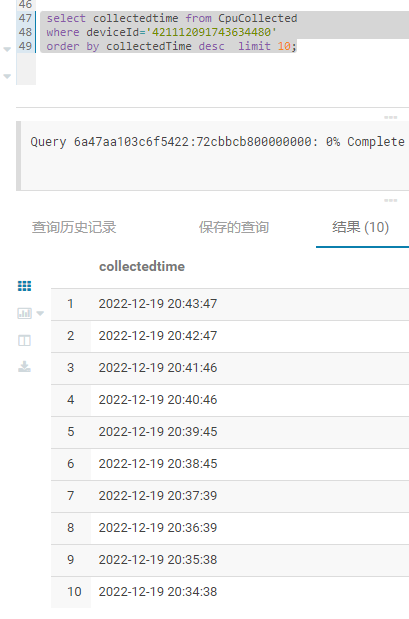

【详述】我们现在用flink批量保存数据,刚开始运行,保存没问题,等运行一段时间之后数据存在丢失情况

【背景】相同数据保存到hbase和sr里面,

【StarRocks版本】例如:2.3

【集群规模】例如:1fe+1be测试环境,正式环境3be

【表模型】明细模型

【导入或者导出方式】Flink,flink-connector-starrocks版本1.2.3_flink-1.13_2.12,sink.buffer-flush.interval-ms:180000,sink.buffer-flush.max-rows:500000,sink.buffer-flush.max-bytes:94371840