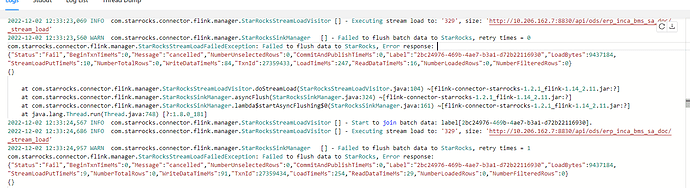

【详述】flink同步SR,一共同步了很多表,但是其中一张表同步出现了异常,日志里看不出异常的原因。消息里光说了个"Message":“cancelled”。

【背景】FlinkCDC同步SR

【业务影响】

【StarRocks版本】2.3

【集群规模】3fe(1 follower+2observer)+4be(fe与be混部)

【机器信息】

【表模型】主键模型

【导入或者导出方式】FlinkCDC导入

【附件】

grep -w $TxnId fe.log|grep “load id”

根据txnid找到load id和be节点ip

grep $load_id be.INFO|less

到指定be节点ip,用刚才找到的load id来查询

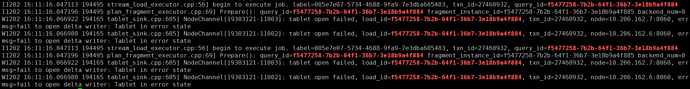

你好,我查询结果是 to open delta writer: Tablet in error state。

这个是因为我建表问题??我是主键模型。

建表DDL(字段太多。删了200多个字段):

CREATE TABLE `erp_inca_bms_sa_doc` ( `etl_partition` varchar(65533) NOT NULL COMMENT "", `salesid` bigint(20) NOT NULL COMMENT "", `flink_etl_time` varchar(65533) NULL COMMENT "" ) ENGINE=OLAP PRIMARY KEY(`etl_partition`, `salesid`) COMMENT "OLAP" DISTRIBUTED BY HASH(`salesid`) BUCKETS 8 ;

使用alter table 删除了200多个字段?

不是的,我的意思是DDL语句一共200多个字段。贴过来太长了。所以只贴进来3个字段。

抱歉让你误读了。

我建表后没有对表进行其他操作。

DDL语句200多个字段具体是指什么操作。

只有4中类型

varchar, bigint, datetime, decimal128

我是主键模型。

建表DDL(字段太多。删了200多个字段):

什么意思,这个主键模型的表一共多少个字段?还删了200多个字段?

CREATE TABLE erp_inca_bms_sa_doc (

etl_partition varchar(65533) NOT NULL COMMENT “”,

salesid bigint(20) NOT NULL COMMENT “”,

… 此处省略200个字段…

flink_etl_time varchar(65533) NULL COMMENT “”

) ENGINE=OLAP

PRIMARY KEY(etl_partition, salesid)

COMMENT “OLAP”

DISTRIBUTED BY HASH(salesid) BUCKETS 8 ;

"enable_persistent_index" = "true"

主键模型把这个加上吧,主键模型数据量太大,最好要有分区键