【详述】

使用flink connector实时导入数据到starrocks,UNIQUE KEY模型表。

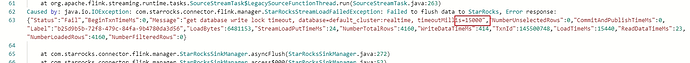

stream load导入返回结果:get database write lock timeout,导致flink任务失败。

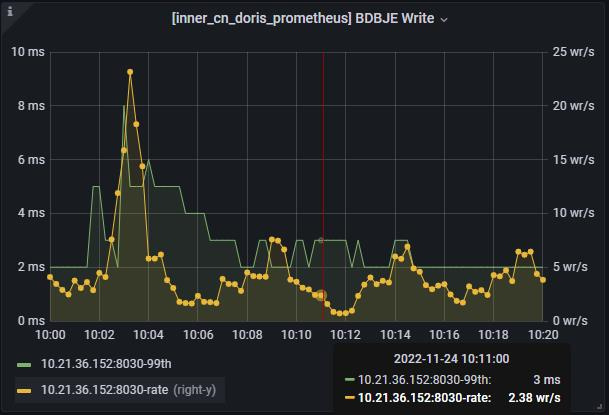

日志时间大约在:2022-11-24 10:11:30

这是当时的元数据同步监控:

【业务影响】

flink实时同步任务失败

【StarRocks版本】

starrocks版本:2.0.1

flink connector starrocks版本:1.1.10_flink-1.11

【集群规模】

3fe(3 follower)+ 3be(fe与be混部)

【机器信息】

48C/188G/万兆