今天集群不太能动,我测试后回复,不过设置成1之后速度会很慢,生产环境这样不太行的

方便提供下您的一个datax任务的json么?

{

“job”: {

“setting”: {

“speed”: {

“channel”: 10,

“byte”: -1

},

“errorLimit”: {

“record”: 0,

“percentage”: 0

}

},

“content”: [

{

“reader”: {

“name”: “postgresqlreader”,

“parameter”: {

“username”: “postgres”,

“password”: “stmedical”,

“column”: [

“report_id”,

“etl_time”,

“exam_time”,

“report_item_id”,

“patient_id”,

“visit_id”,

“visit_type”,

“item_name”,

“exam_indicator_normal_range”,

“exam_indicator_method”,

“exam_indicator_unit”,

“exam_indicator_value”

],

“splitPk”: “id”,

“connection”: [

{

“table”: [

“public.examination_items”

],

“jdbcUrl”: [

${args1}

]

}

]

}

},

“writer”: {

“name”: “starrockswriter”,

“parameter”: {

“username”: “admin2”,

“password”: “stmedical”,

“database”: “rdr_test_1111”,

“table”: “rdr_examination_items_LF”,

“column”: [

“EMGRPID”,

“ETLDTC”,

“LFDTC”,

“RPSUBID”,

“USUBJID”,

“VISITNUM”,

“VTYPE”,

“LFIMNAM”,

“LFIMNRAG”,

“LFIMTYPE”,

“LFIMUNIT”,

“LFIMVAL”

],

“connection”: [

{

“jdbcUrl”: [“jdbc:mysql://10.151.217.4:9030/”,“jdbc:mysql://10.151.217.3:9030/”,“jdbc:mysql://10.151.217.5:9030/”]

}

],

“loadUrl”: [“10.151.217.3:8030”, “10.151.217.4:8030”,“10.151.217.5:8030”],

“loadProps”: {}

}

}

}

]

}

}

jvm参数都给的4g

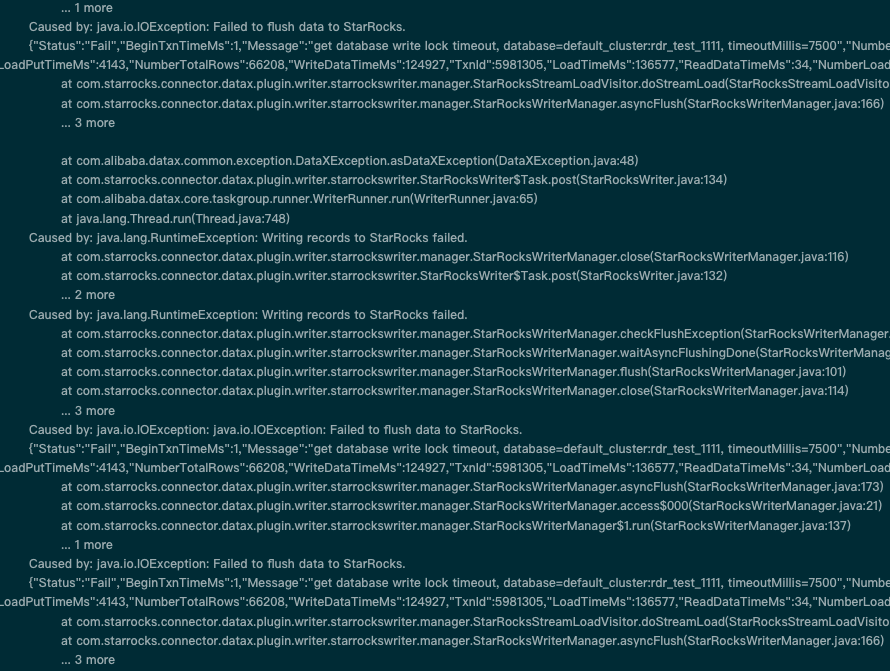

你好,感谢你的建议,设置成1之后,稳定运行,但是速度下降比较严重,只有几千条每秒了,但是磁盘io也降下来了,之前按照主键切分挺快的,有5w/s的样子。

导入频率太高是会出现这个问题的。后续使用时可以注意下,另外不应定非要1咱们目前的任务数量可以设置为 5看下。

我大部分是5,只有大数据量的才是10,稍等我测试一下

测试了,会出现同样的报错,目前还不确定任务挂不挂,重试几次应该会挂的

可以测一下看看,适当增大些channel。

让我继续增大channel吗?能否确认一下大概是什么问题导致的,这个sr官方解决吗?有没有什么比较可行的解决方案

txn_commit_rpc_timeout_ms 您在增大些这个参数来观察下。

问题原因是 库级别有很多的写入任务引起的。 starrocks底层有一把db锁来保证元数据一致性,写入任务很多时就会出现这个问题。我们先控制下channel来调整下。

如果是这样,streaming load是不是都会存在这种问题,如果我用flink高并行度写入,怎么做呢?只能设置为1吗?同时broker load多个任务呢?这边datax如果比较慢,为准备用hive作为中转了

理论上是都会存在这个问题的

be的配置txn_commit_rpc_timeout_ms可以调大到20000看看

这个默认值不就是20000吗

2.4版本默认改成20000了,2.3版本默认是10000