【详述】问题详细描述

创建hive catalog,正常查询hive cdh6 hive表数据,删除hive表分区下的文件,查询hive catalog 表报错,修改hive表分区下的文件名,查询hive catalog表报错

【背景】做过哪些操作?

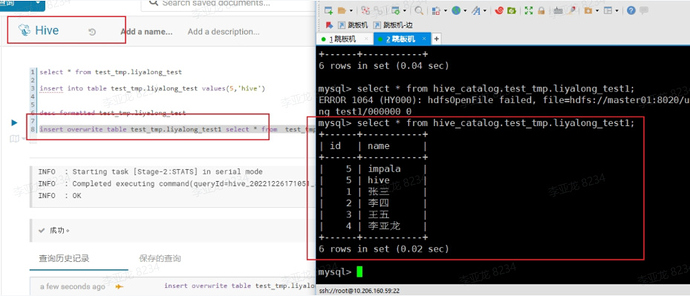

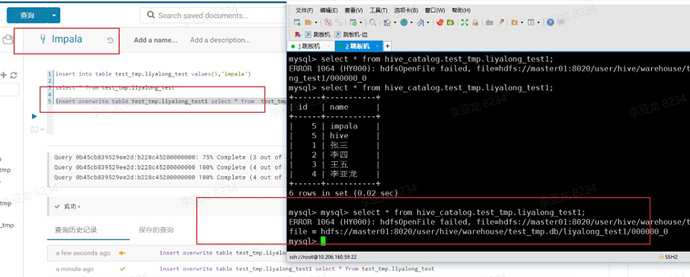

- 创建hive catalog ,cdh6.3.2,配置增量同步hive 元数据,查询hive外表正常

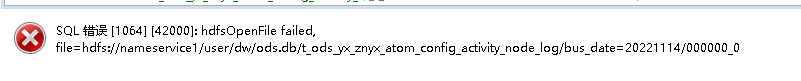

- 删除hive 表table a 20220114分区下的文件,分区目录不变,starrocks查询table a 报错,提示读取hdfs文件报错,文件还是删除前的文件名

- 修改hive 表table a 20220114分区下的文件,分区目录不变,starrocks查询table a 报错,提示读取hdfs文件报错,文件还是修改前的文件名

- 删除hive表,重建hive表,重新插入hive表数据,查询正常了

【业务影响】

【StarRocks版本】例如:2.3.0

【集群规模】例如:3fe(1 follower+2observer)+3be(fe与be混部)

【机器信息】CPU虚拟核/内存/网卡,例如:48C/256G/万兆

【附件】