SR版本2.4.0

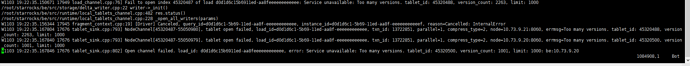

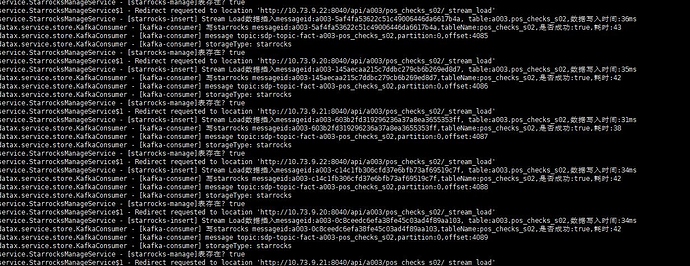

场景: stream load消费kafka中message,每个message中100条数据,将100条数据发送一次stream load。每次http时间在50ms左右,然后再进行下一次消费。

机器: 3台 16core * 64G be 独享机器

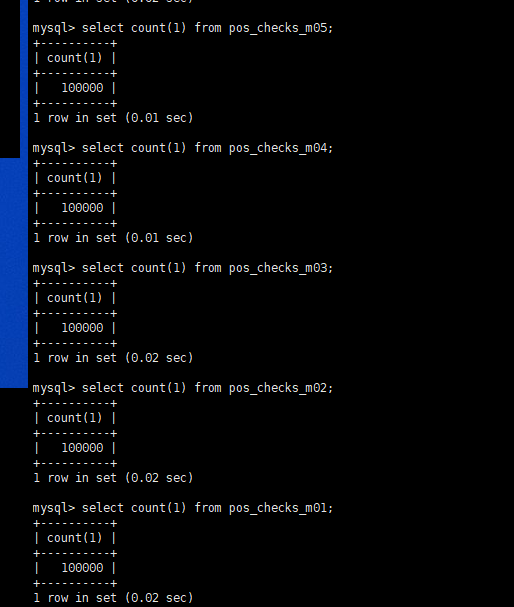

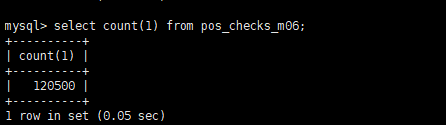

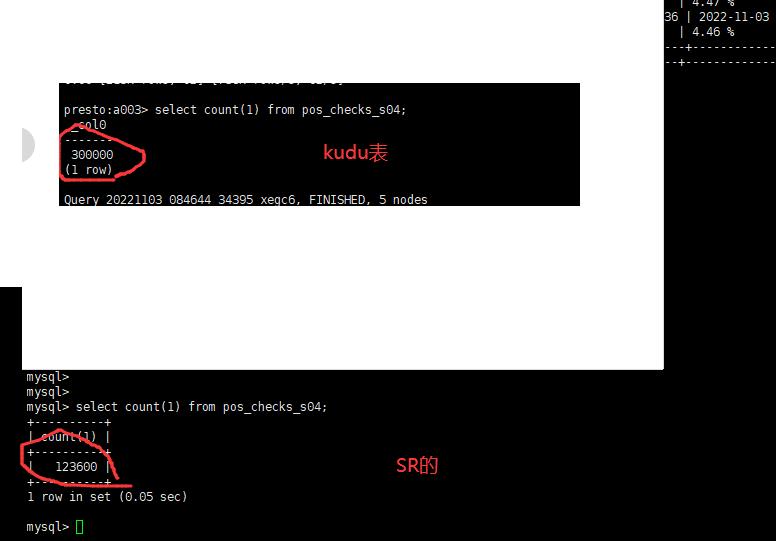

测试案列: 消费kafka中3000批次数据(共30W条) 同样的数据即写了kudu 又写了SR

消费完成后 kudu数据为30W条,但是SR的数据只有20多万条,试过明细模型 、更新模型 、 主键模型均存在丢失数据的情况,

测试过程中保证消费offset准确 以及stream load请求次数准确且返回状态值均为200

但是如果只消费10W数据的话, 共测试四次数据均没有丢失,

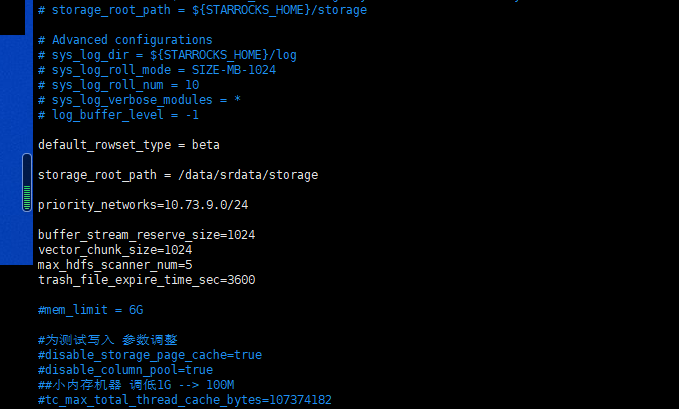

配置: be配置参数:

,方便加个微信不 我把群里沟通聊天记录发你看下

,方便加个微信不 我把群里沟通聊天记录发你看下