报错:

ERROR 1064 (HY000): StarRocks planner use long time 3000 ms, This probably because 1. FE Full GC, 2. Hive external table fetch metadata took a long time, 3. The SQL is very complex. You could 1. adjust FE JVM config, 2. try query again, 3. enlarge new_planner_optimize_timeout session variable

首次查询就会报上面的错误,再次查询就没有这个问题,这个正常吗?还是哪里能配置下 提前预热

表结构也不是特别复杂;

可以refresh下分区,REFRESH EXTERNAL TABLE hive_t PARTITION (‘k1=01/k2=02’, ‘k1=03/k2=04’)

我也遇到这个问题

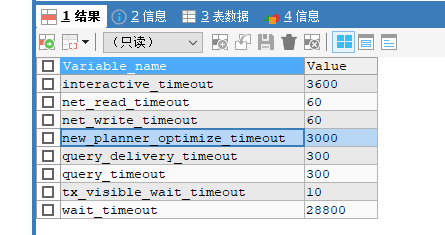

starrock 2.4.2 也有这个问题,不知道调整什么,因为参数已经很大了:

这个受限于,Hdfs读取的速度,第一次读会拉取元数据,本身就很慢。可以通过在查询前,或是定期refresh 下,来规避。

2.5彻底解决了这个问题

目前我们用的2.5.1还有改问题