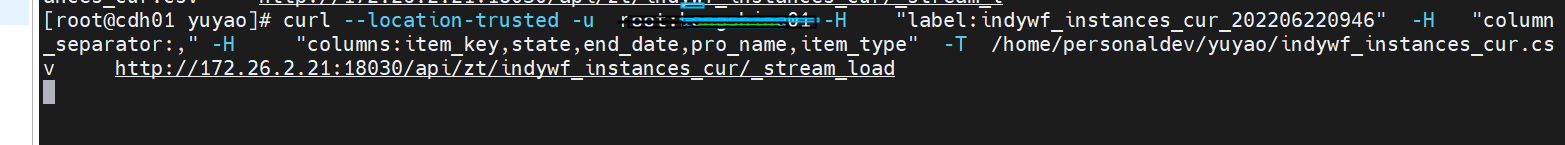

通过stream_load导入csv文件,不报错,但后台也查不到数据

您好,方便的话请发下导入任务的返回结果

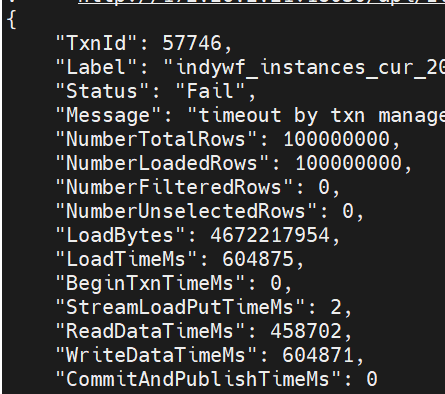

timeout by txn manager

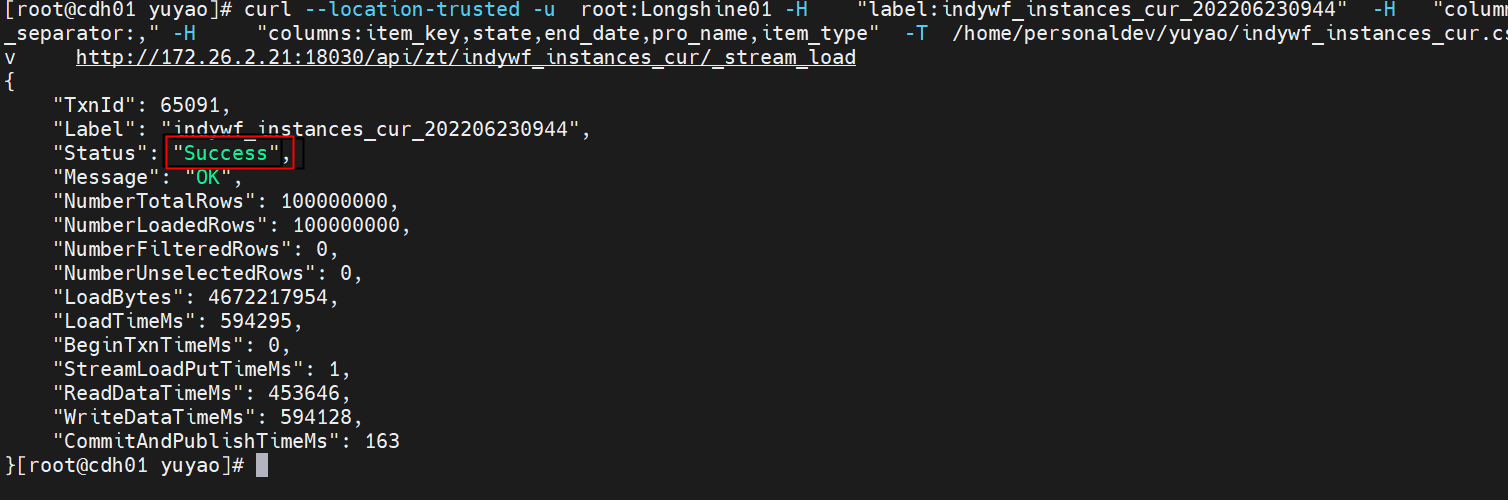

上面的就是结果,导入的数据是1亿,不知道是不是因为数据量太大导致的,但是没超过10g

导入的status是fail 看下message详细信息,这只能看到部分。有errorurl吗?有的话curl下看看有没有结果?

返回的信息结果中 没有 errorurl,只有一个 timeout by txn manager

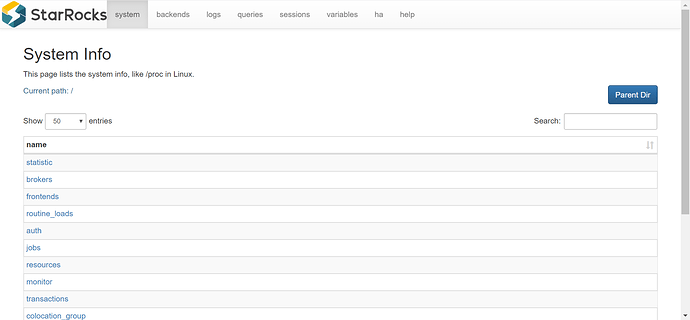

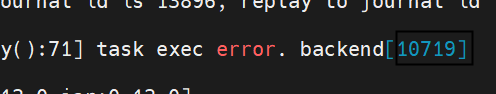

1.grep -w $TxnId fe.log|grep “load id” 看下本次导入的load_id和调度到的be节点

2.到对应的be节点执行:grep $load_id be.INFO|less

然后发下结果看下

这个是load_id

我不是用flink导入的,sink.buffer-flush.enqueue-timeout-ms这个参数我这边没办法设置,我看网上有参数设置是load_mem_limit,设置大点

报错是事务超时,txn_commit_rpc_timeout_ms调整下这个参数,改大点试下

这种情况数据可能被过滤掉了,请问导入的是什么表呢?

有可能是主键有重复,导致给过滤掉了,我再重新试下