为了更快的定位您的问题,请提供以下信息,谢谢

【详述】打印高频打印重复日志 fe `tadataMgr$QueryMetadatas.getConnectorMetadata():121

2025-12-11 10:05:00.756+08:00 INFO (starrocks-mysql-nio-pool-2410|138766) [MetadataMgr$QueryMetadatas.getConnectorMetadata():121] Succeed to register query level connector metadata [catalog:hive, queryId: cce389ac-d635-11f0-b952-00163e0b6d2b]

2025-12-11 10:05:00.773+08:00 INFO (starrocks-mysql-nio-pool-2410|138766) [MetadataMgr.removeQueryMetadata():212] Succeed to deregister query level connector metadata on query id: Optional[cce389ac-d635-11f0-b952-00163e0b6d2b]

2025-12-11 10:05:00.844+08:00 INFO (starrocks-mysql-nio-pool-2410|138766) [MetadataMgr$QueryMetadatas.getConnectorMetadata():121] Succeed to register query level connector metadata [catalog:hive, queryId: ccf0d022-d635-11f0-b952-00163e0b6d2b]

2025-12-11 10:05:00.847+08:00 INFO (starrocks-mysql-nio-pool-2410|138766) [MetadataMgr.removeQueryMetadata():212] Succeed to deregister query level connector metadata on query id: Optional[ccf0d022-d635-11f0-b952-00163e0b6d2b]

2025-12-11 10:05:00.900+08:00 INFO (starrocks-mysql-nio-pool-2410|138766) [MetadataMgr$QueryMetadatas.getConnectorMetadata():121] Succeed to register query level connector metadata [catalog:hive, queryId: ccf95ba4-d635-11f0-b952-00163e0b6d2b]

【背景】升级StarRocks 到StarRocks-3.5.7

【业务影响】

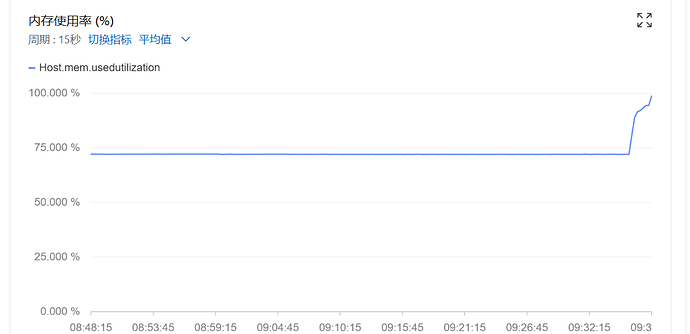

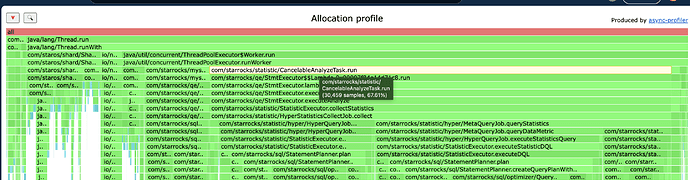

每3天会突发一次FE 挂掉,内存 突然暴涨

【是存算分离】是

【StarRocks版本】StarRocks-3.5.7

【集群规模】例如:3fe(3 follower)+6be(fe与be独立部署)

【机器信息】CPU虚拟核/内存/网卡,例如:8C/64G/万兆

【联系方式】为了在解决问题过程中能及时联系到您获取一些日志信息,请补充下您的联系方式,例如:社区群4-小李或者邮箱,谢谢

【附件】

- fe.log/beINFO/相应截图

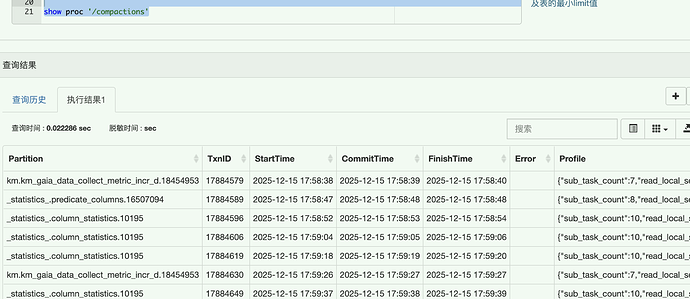

- 慢查询:

-

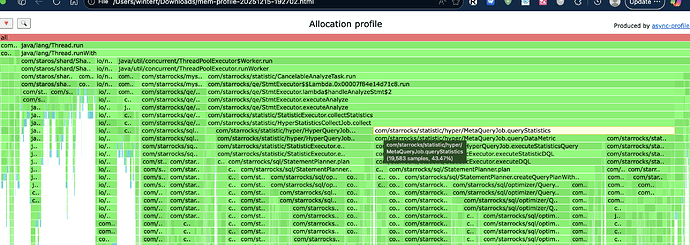

Profile信息,获取Profile,通过Profile分析查询瓶颈

-

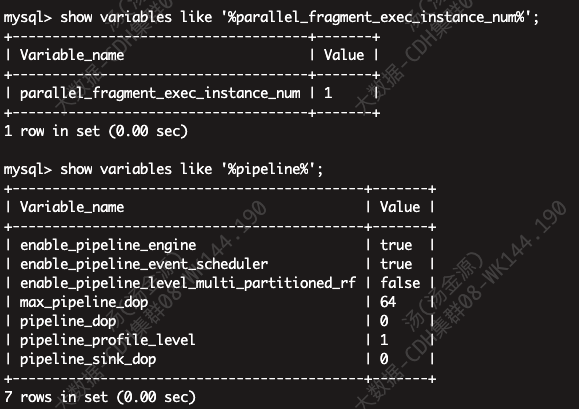

并行度:show variables like ‘%parallel_fragment_exec_instance_num%’;

-

pipeline是否开启:show variables like ‘%pipeline%’;

-

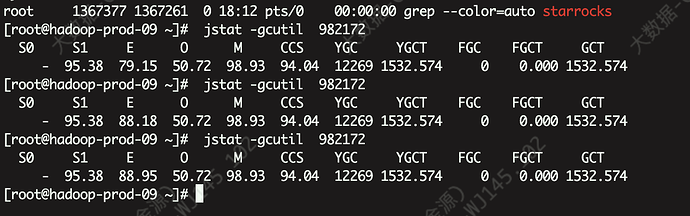

fe内存

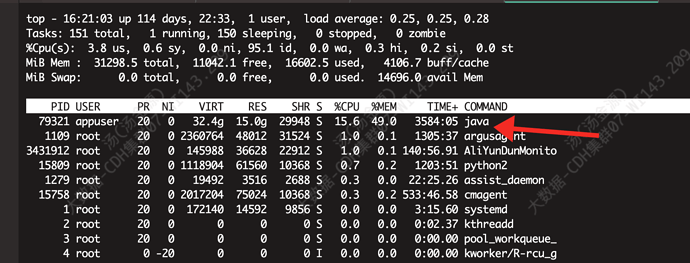

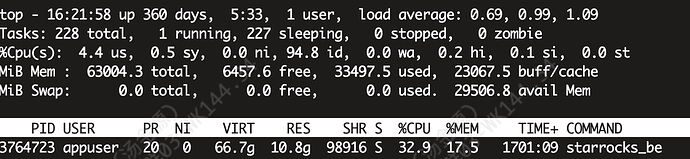

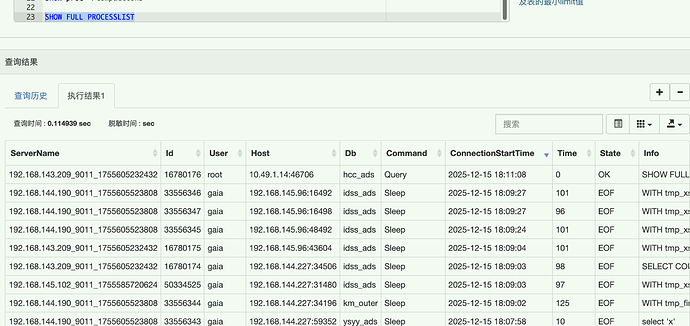

be内存 正常使用情况

宕机的时候

现在近10000行fe日志;

fe10000.log.tar.gz (111.6 KB)

尝试过

1、刷新元数据

REFRESH EXTERNAL TABLE hive.yf_ads.yf_ads_trade_XX_full_d;

REFRESH EXTERNAL TABLE hive.yf_ads.yf_ads_trade_XX_summary_full_d;

REFRESH EXTERNAL TABLE hive.yf_ads.yf_ads_trade_XX_full_d

PARTITION (‘pt_d=new’);

REFRESH EXTERNAL TABLE hive.yf_ads.yf_ads_trade_XX_summary_full_d

PARTITION (‘pt_d=new’);

2、修改元数据相关参数

– 核心:扩大 Catalog 元数据缓存条目数

ADMIN SET FRONTEND CONFIG (“catalog_metadata_cache_size” = “50000”);

– 适配:同步 FE 元数据刷新间隔为15分钟

ADMIN SET FRONTEND CONFIG (“background_refresh_metadata_interval_millis” = “900000”);

ALTER CATALOG hive set (

– 1. 保持缓存开启(核心!关闭会彻底不缓存,加剧频繁请求HMS)

“enable_metastore_cache” = “true”,

“enable_remote_file_cache” = “true”,

“enable_cache_list_names” = “true”, – 缓存分区名,减少分区列表查询

-- 2. 延长元数据刷新间隔(从默认60s→900s=15分钟)

-- 逻辑:低更新场景,15分钟刷新一次足够,减少频繁异步更新

"metastore_cache_refresh_interval_sec" = "900",

"remote_file_cache_refresh_interval_sec" = "900", -- 与表元数据刷新间隔保持一致

-- 3. 延长缓存淘汰时间(从默认24h→72h=259200s)

-- 逻辑:延长缓存寿命,避免频繁淘汰后重复从HMS加载元数据(减少register/deregister)

"metastore_cache_ttl_sec" = "259200",

"remote_file_cache_ttl_sec" = "345600", -- 文件元数据变化更少,淘汰时间比表元数据长(96h)

-- 4. 限制缓存内存占比(从默认10%→5%,3.5.6+支持)

-- 逻辑:缓解FE内存紧张,避免文件元数据缓存占用过多堆内存

"remote_file_cache_memory_ratio" = "0.1"

)

最后还是不能解决问题;

打印大量的connector metadata日志

12月12日7点又宕机了

2025-12-12 07:32:35.363+08:00 INFO (MemoryUsageTracker|67) [MemoryUsageTracker.trackMemory():165] (0ms) Module TabletInvertedIndex - TabletInvertedIndex estimated 45.7MB of memory. Contains TabletMeta with 666797 object(s). TabletCount with 666797 object(s). ReplicateCount with 0 object(s).

2025-12-12 07:32:35.363+08:00 INFO (MemoryUsageTracker|67) [MemoryUsageTracker.trackMemory():165] (0ms) Module Task - TaskManager estimated 1.4KB of memory. Contains Task with 17 object(s).

2025-12-12 07:32:35.363+08:00 INFO (MemoryUsageTracker|67) [MemoryUsageTracker.trackMemory():165] (0ms) Module Task - TaskRunManager estimated 0B of memory. Contains PendingTaskRun with 0 object(s). RunningTaskRun with 0 object(s). HistoryTaskRun with 0 object(s).

2025-12-12 07:32:35.363+08:00 INFO (MemoryUsageTracker|67) [MemoryUsageTracker.trackMemory():165] (0ms) Module Transaction - GlobalTransactionMgr estimated 1.9MB of memory. Contains Txn with 8001 object(s). TxnCallbackCount with 1 object(s).

2025-12-12 07:32:35.364+08:00 INFO (MemoryUsageTracker|67) [MemoryUsageTracker.trackMemory():112] total tracked memory: 73.3MB, jvm: Process used: 27.4GB, heap used: 21.7GB, non heap used: 320.8MB, direct buffer used: 73.1MB

MemoryUsageTracker.log (33.9 KB)