为了更快的定位您的问题,请提供以下信息,谢谢

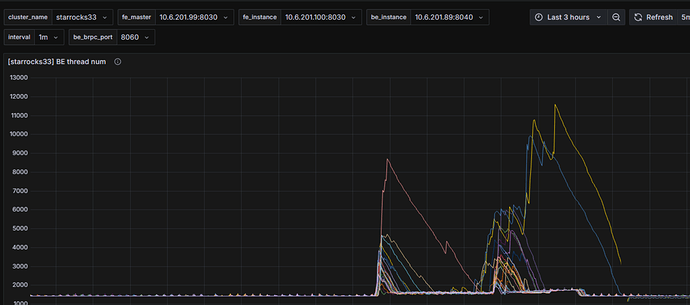

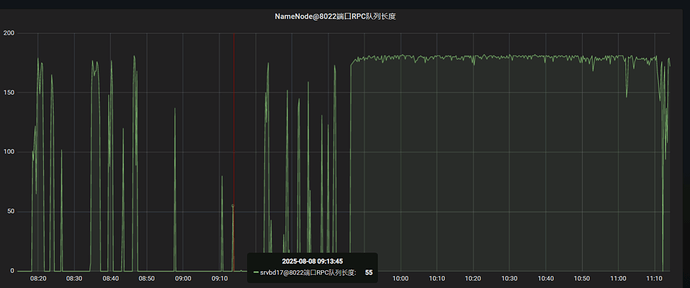

【详述】starrocks3.3版本使用hive做为外部表,在读取dfs时导致namenode和datanode的rpc连接过高。

【背景】使用starrocks读取hive表进行宽表打宽重写回hive中。

hadoop集群是300个节点的CDH5.16.1

数据量 80亿 关联 30亿 再关联 30亿

字段50个

【业务影响】rpc过高导致集群上任务延迟。

【是否存算分离】否

【StarRocks版本】例如:3.3

【集群规模】3fe(1 follower+2observer)+24be(fe与be混部)

【机器信息】CPU虚拟核/内存/网卡,例如:48C/512G/万兆

【联系方式】fengchao723@163.com

【附件】

- Profile信息,如何获取profile

- 并行度:show variables like ‘%parallel_fragment_exec_instance_num%’;

show variables like ‘%pipeline_dop%’; - pipeline是否开启:show variables like ‘%pipeline%’;

- 执行计划:explain costs + sql

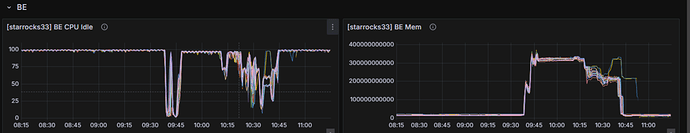

- be节点cpu和内存使用率截图