为了更快的定位您的问题,请提供以下信息,谢谢

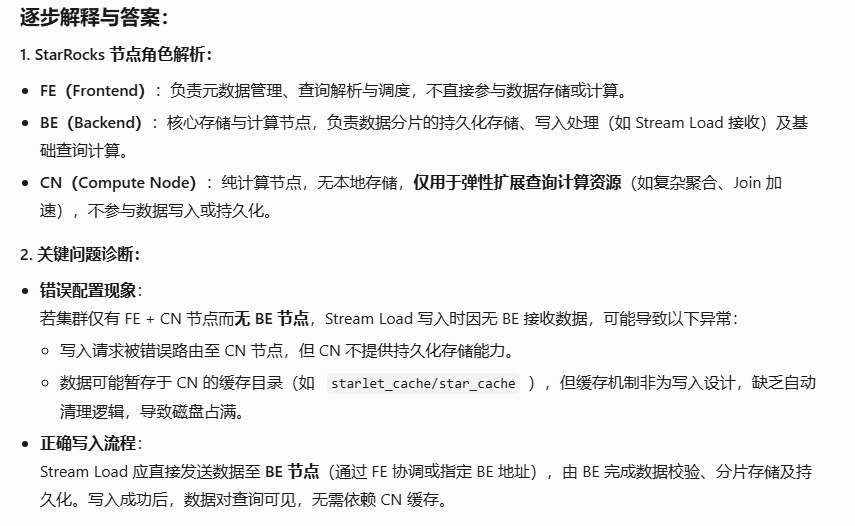

【详述】StreamLoad场景下CN节点starlet_cache/star_cache下数据持续增长直至磁盘占满,没有清理机制吗?

【背景】做过哪些操作?

【业务影响】

【是否存算分离】是

【StarRocks版本】例如:3.3.7

【集群规模】例如:1fe+1be+1cn

【机器信息】26C/52G/万兆

【表模型】明细表

【导入或者导出方式】Stream Load(Flink1.17)

【联系方式】501508468@qq.com

【附件】

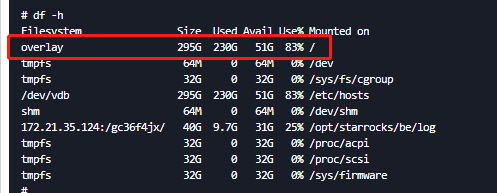

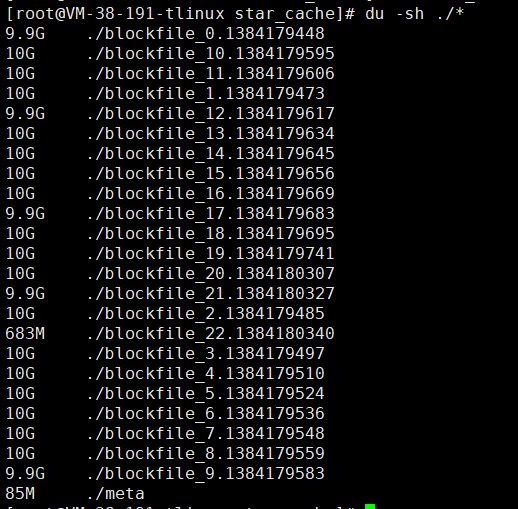

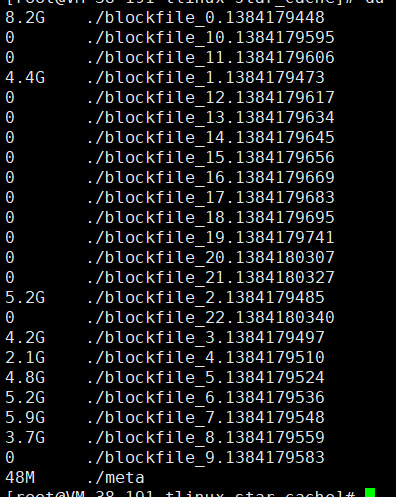

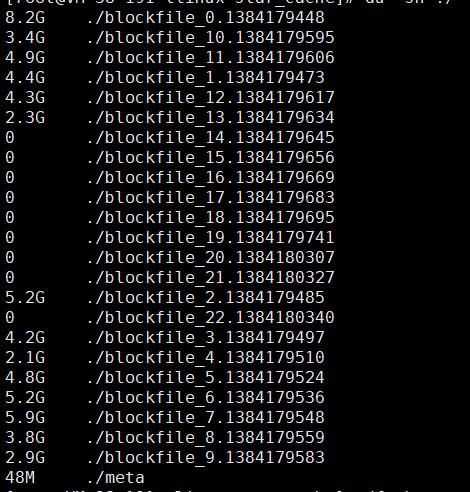

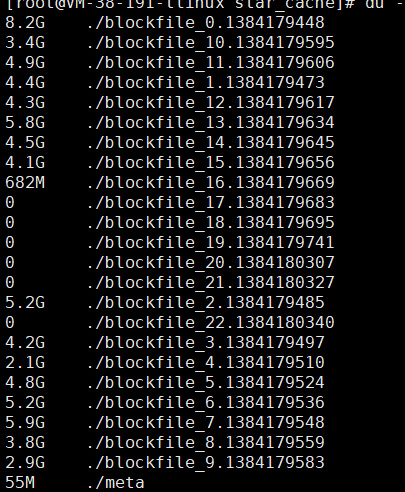

经排查,是 starlet_cache/star_cache目录下的文件过大导致磁盘占满后,CN崩溃。截图了一些Stream Load在CN上的该目录的文件大小统计(只是一部分)。

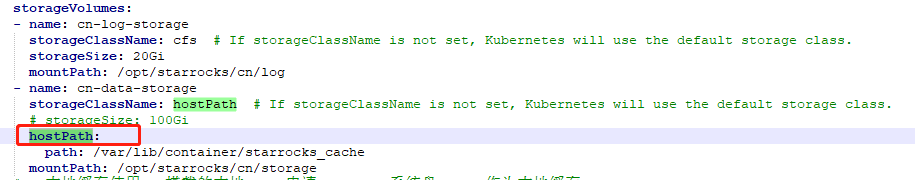

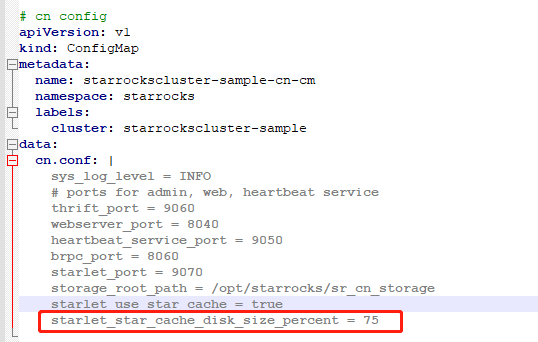

设置starlet_star_cache_disk_size_percent = 75,发现star_cache目录下的文件仍然持续增长,直到CN磁盘打满。CN使用的是hostPath,通过物理节点做了磁盘大小的限制。为什么这些block文件不会自动清理?