【详述】

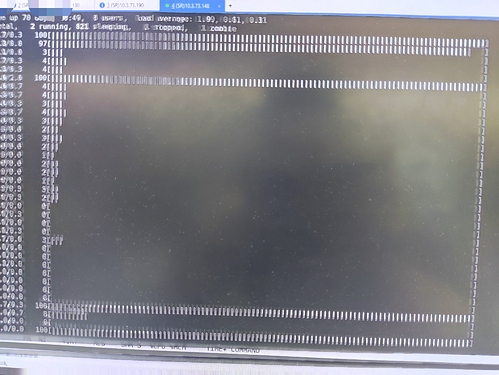

1、SR2.1.1 集群多表Join查询,cpu使用率低(单机环境单核使用率可以达到70%+,集群环境集中在单核使用率高,其余核未使用),集群查询cpu使用情况如下:

2、集群使用pipline引擎后单并发查询效率变低,耗时如下:

并发数 | 未使用pipline引擎,16并行度 | 使用pipline引擎

1 | 15203 ms | 32486ms

5 | 66054 ms | 35935ms

10 | 132736ms | 40173ms

3、具体的建表语句和pipline执行引擎下5并发查询的prodile,explain文件见附件,

4、补充下表的数据量:

tb1:136

tb2:1461163

tb3:36239136

tb4:72164999

tb5:90176573

麻烦问下各位大佬,有何可以优化的配置?

【StarRocks版本】2.1.1

【集群规模】1fe(1 follower)+3be(fe与be混部)

【机器信息】三机器集群,单机配置:80C/512G/千兆

【附件】

create.sql (2.6 KB) profile.txt (83.4 KB)

explain.txt (70.9 KB)