为了更快的定位您的问题,请提供以下信息,谢谢

【详述】问题详细描述

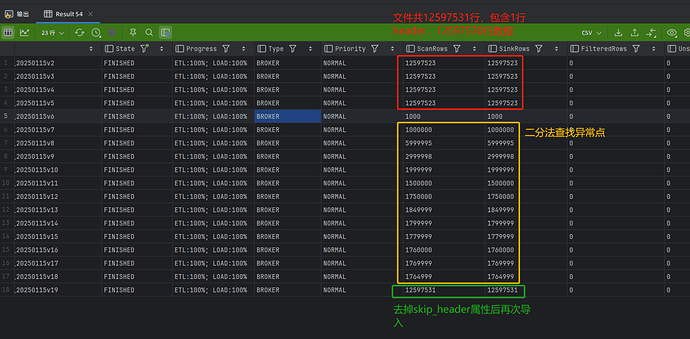

通过BrokerLoad导入NAS路径中挂载的文件时,配置skip_header属性为1,实际跳过了多行而不是1行。内部实现是否存在将一个CSV文件拆分为多个的机制?

【背景】做过哪些操作?

通过BrokerLoad导入标准的逗号分隔值文件。

【业务影响】

导入文件数据量级不对。

【是否存算分离】否

【StarRocks版本】例如:3.1.14

【集群规模】6fe+8be(fe与be混部)

【机器信息】32C、128G,千兆

【表模型】聚合模型、主键模型均存在该问题

【导入方式】Broker Load读取挂载到本地的NAS

【联系方式】zhongpengcheng@npnets.com

【附件】

表定义(已做脱敏):

CREATE TABLE table_aa

(

dt date NOT NULL COMMENT '',

col1 varchar(128) NULL COMMENT '',

col2 varchar(128) NULL COMMENT '',

col3 varchar(128) NULL COMMENT '',

col4 varchar(128) NULL COMMENT '',

col5 varchar(128) NULL COMMENT ')',

col6 varchar(128) NULL COMMENT '',

col7 varchar(128) NULL COMMENT ''

) ENGINE = OLAP

DUPLICATE KEY(dt)

PARTITION BY date_trunc('day',dt)

DISTRIBUTED BY HASH(dt);

BrokerLoad语句:

-- 提交Broker Load

LOAD LABEL xx.yyy_20250115v19 (

DATA INFILE("file:///xxx")

INTO TABLE table_aa

COLUMNS TERMINATED BY ','

FORMAT AS 'CSV'

-- (

-- skip_header = 1

-- )

(col1, col2, col3, col4, col5, col6, col7)

SET (

dt='2025-01-15',

col1=col1,

col2=col2,

col3=col3,

col4=col4,

col5=col5,

col6=col6,

col7=col7)

)

WITH BROKER

PROPERTIES

(

"timeout" = "3600",

"strict_mode" = "true"

);

导入文件大小907.23 MB,共12597531行(1行头,12597530行数据)