为了更快的定位您的问题,请提供以下信息,谢谢

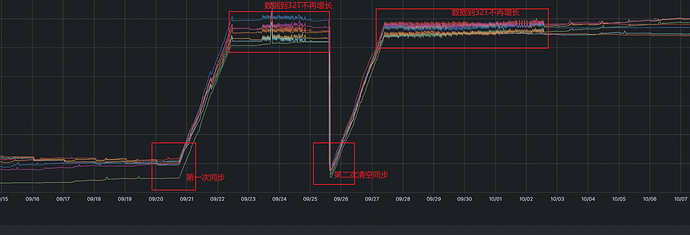

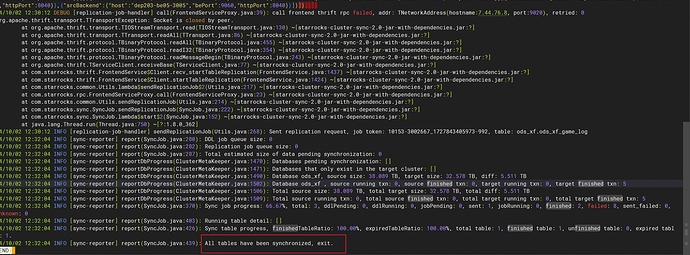

【详述】在做跨集群数据迁移的时候,程序迁移到32T后就直接退出,还有5T数据待迁移完毕

【背景】试过几个动作: 1. 修改过好几次同步参数,重启程序迁移(无效果) 2. 清除目标集群已同步的所有数据,重新开始同步(无效果)

【业务影响】 直接导致两边集群数据不一致

【是否存算分离】否

【StarRocks版本】源集群版本:v3.1.2 目标集群版本:v3.2.8

【集群规模】源集群:3FE 16g/8c/100g 7BE 64g/32C/10T

目标集群:3FE 64g/32c/200g 7BE 64g/32C/10T

【机器信息】 64g/32C/万兆

【表模型】明细模型

【导入或者导出方式】 starrocks-cluster-sync工具

【联系方式】hsdcloud#163.com

【附件】

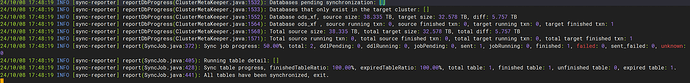

- 开启debug级别日志后,有下面的日志,不清楚具体什么意思?(忽略复制动作?)

24/10/08 18:12:44 DEBUG [replication-job-handler] create(GenericPool.java:106): before create socket hostname=7.44.76.10 key.port=9020 timeoutMs=600000

24/10/08 18:12:44 DEBUG [replication-job-handler] sendReplicationJob(Utils.java:255): Ignore the replication job 10153-3002667_1728382361526-1 to TNetworkAddress(hostname:7.44.76.10, port:9020), table: ods_xf.ods_xf_game_log, detail message: Replication job of table 3002667 is already running