为了更快的定位您的问题,请提供以下信息,谢谢

【详述】现在我有一个业务场景,根据估算,数据的极值大概就是121万的数据需要跟另外几千的数据形成一个笛卡尔积的大表。约单表40亿以上的量,按天分区,需要使用到主键表。

1:按照业务需求,其实应该放在OLTP类型的数据库中,比如mysql,tidb等等。

2:当前业务系统,如果完全使用关系型数据库,会跟其他业务系统混合部署,大批量数据初始化的时候会影响其他系统稳定性,所以不得已需要拆出独立数据库

3:mysql和TIDB ,单表40亿,用起来都不太现实,分表要上千张,分区的话,做某些查询又会很不方便,性能也跟不上,内存也吃不消。而且分区维护管理很复杂。

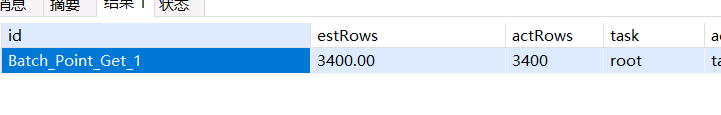

因为只有这么一张表特别大,而且必须长期留存,每年大概都是这个量,需要6年及以上。现在想请问一下,使用StarRocks的主键表做这种业务数据的存储+简单的单表 in / not in / group by / distinct / count 等sql。

是否合适?

主键表能不能当作OLTP类型的库表来使用?

有什么风险?

【背景】都是销售签合同的时候留的坑啊,客户抓到漏洞,数据量和要求直接翻了70倍!!

【业务影响】

【是否存算分离】

【StarRocks版本】例如:3.3.0

【联系方式】wp_space@163.com