【详述】问题详细描述

查询maxcompute catalog表时,首次查询耗时8-9s,接下来查询稳定在3s左右

【背景】做过哪些操作?

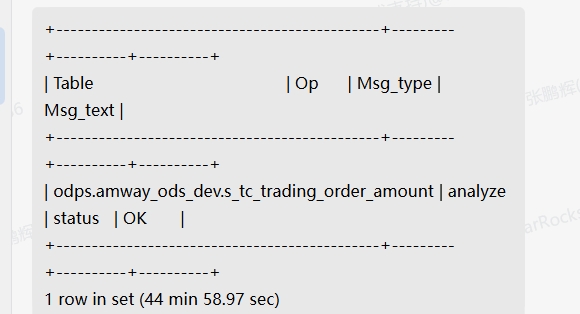

手动收集maxcompute catalog表的CBO信息时,耗时44min左右

【是否存算分离】是

【StarRocks版本】3.3.0

catalog创建SQL:

CREATE EXTERNAL CATALOG odps

PROPERTIES (“odps.access.id” = “LTPR",

“odps.access.key” = "PfeD”,

“odps.project” = “amway_ods”,

“odps.tunnel.quota” = “PROD”,

“odps.endpoint” = “http://service.cn-shenzhen.maxcompute.aliyun.com/api”,

“type” = “odps”

);

- 慢查询:

- Profile信息

maxcompute_profile.txt (31.4 KB)

8s_profile.txt (32.0 KB)

- Profile信息