【详述】 使用spark-connector 从hive导入 SR中 大数据量时导入失败

【背景】做过哪些操作?

spark 读取hive表数据进行列转行后导入SR中 1000万9列 数据时正常,5000万9列 列传行后导入失败

1000万9列 转成行为9000万数据

5000万9列 转成行为 4亿5千万数据 导入数据失败。

【业务影响】

【是否存算分离】无

【StarRocks版本】例如:3.0.9

【connector版本】 spark-connector 1.1.1

【集群规模】例如:3fe(1 follower+2observer)+3be(fe与be混部)

【机器信息】CPU虚拟核/内存/网卡,例如:8C/32G/万兆

【联系方式】社区群9-龙飞

【附件】

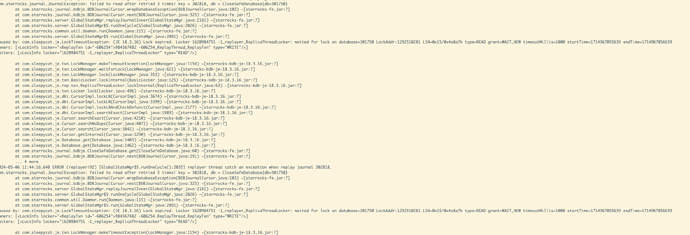

- 导入报错

- leader fe.log/be.INFO/flink日志相应截图

- leader fe.log/be.INFO/flink日志相应截图

- 导入性能不足

- profile