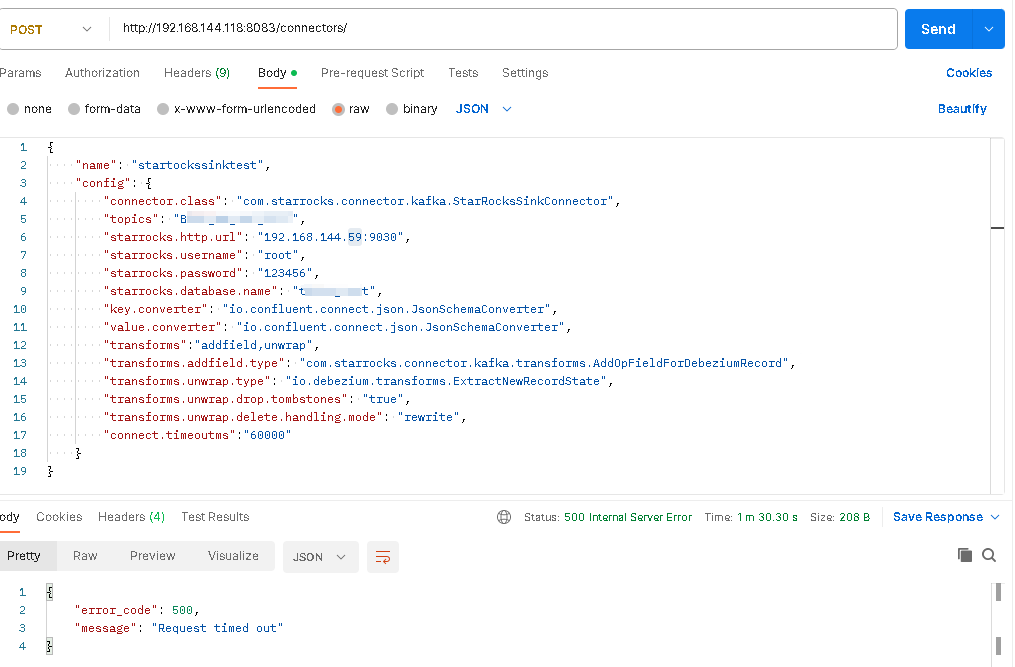

【详述】通过kafka connect 导入debezium cdc+oracle数据 ,按照官方文档配置导入失败 配置如下:

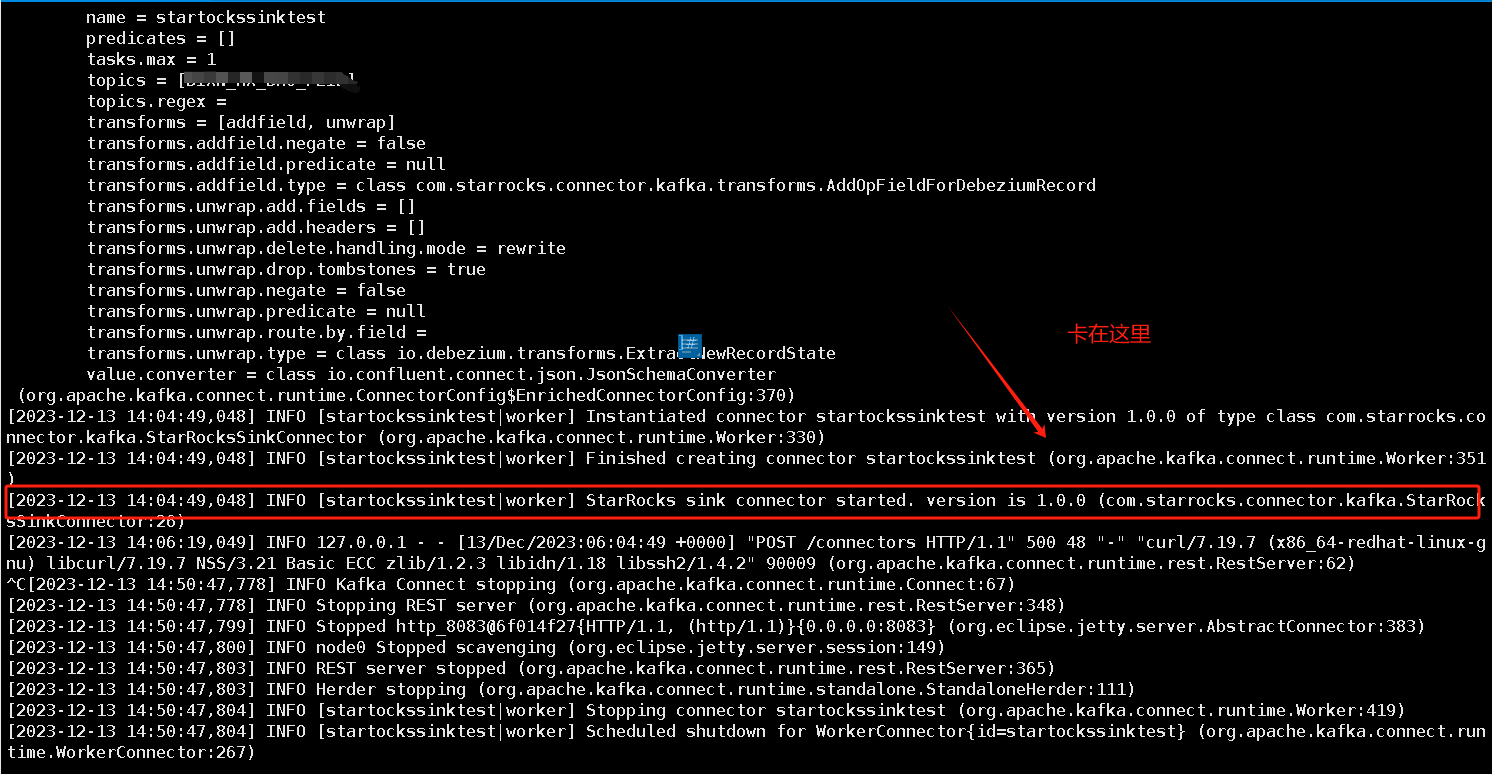

试了kafka 2.13-3.6.0和confluent-community 7.5.2 提交sink 请求后都卡住,最后请求超时如图,

去掉配置

“transforms.addfield.type”: “com.starrocks.connector.kafka.transforms.AddOpFieldForDebeziumRecord”,

“transforms.unwrap.type”: “io.debezium.transforms.ExtractNewRecordState”,

“transforms.unwrap.drop.tombstones”: “true”,

“transforms.unwrap.delete.handling.mode”: “rewrite”,

并将convert 改为org.apache.kafka.connect.json.JsonConverter可以解决卡死问题,但是无法消费数据

【是否存算分离】否

【StarRocks版本】2.5 【kafka版本】2.13-3.6.0 【confluent版本】community 7.5.2

【集群规模】3fe(1 follower+2observer)+3be(fe与be混部)

【机器信息】CPU虚拟核/内存/网卡,例如:16C/64G

【表模型】主键模型

【导入或者导出方式】例如:Flink

【联系方式】

【附件】

- fe.log/be.INFO/相应截图

- 完整的报错异常栈