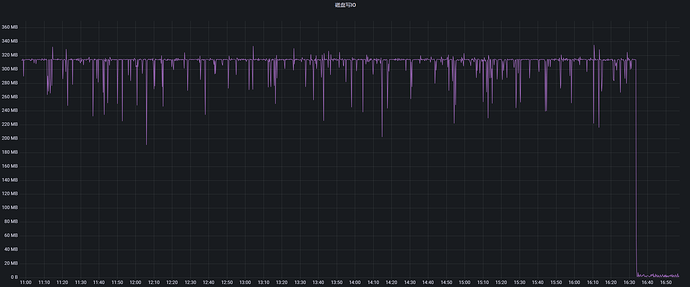

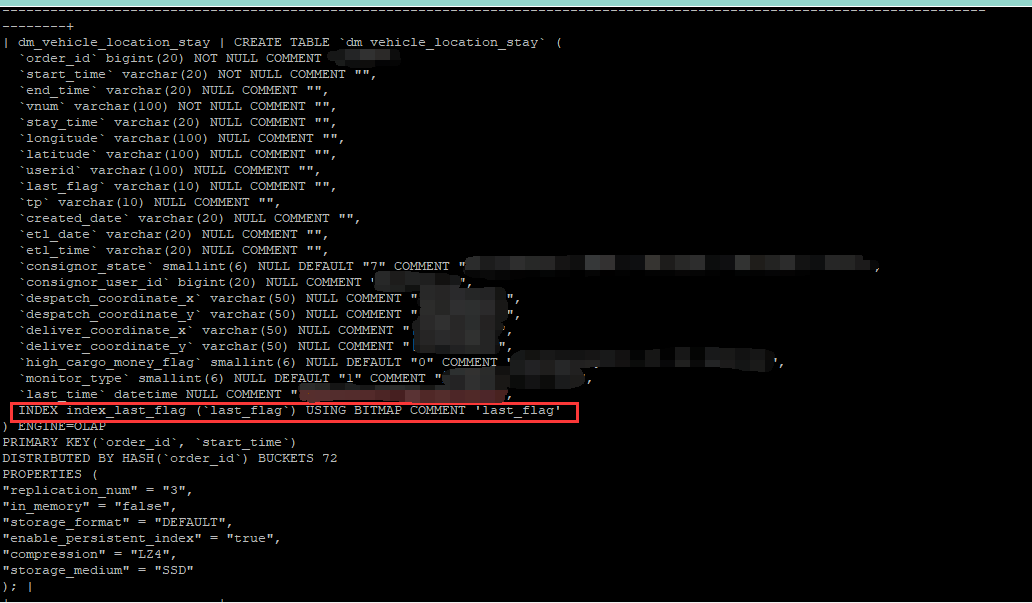

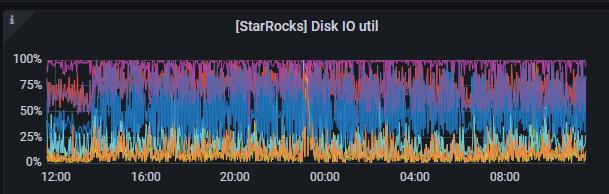

【详述】目前4台be节点,每台节点1块hdd盘和1块ssd盘,之前hdd盘的io打满每台机器扩容了1块ssd盘,扩容后io恢复正常,最近持续一周ssd盘的io也被打满,没发现有频繁大量写入操作,业务侧主要是spark的steamload方式写入数据

【业务影响】

【StarRocks版本】例如:2.5.11

【集群规模】3fe+3be(fe与be混部)

【机器信息】12C/48G

【联系方式】社区群3-Mr。xiao

【附件】

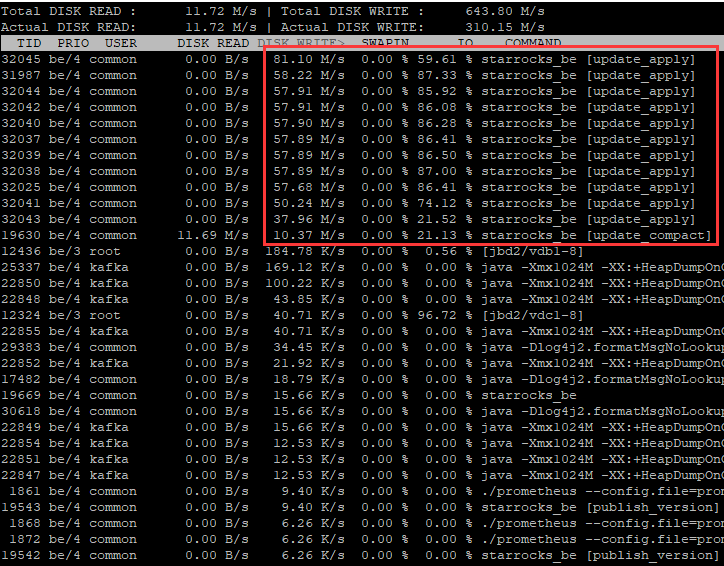

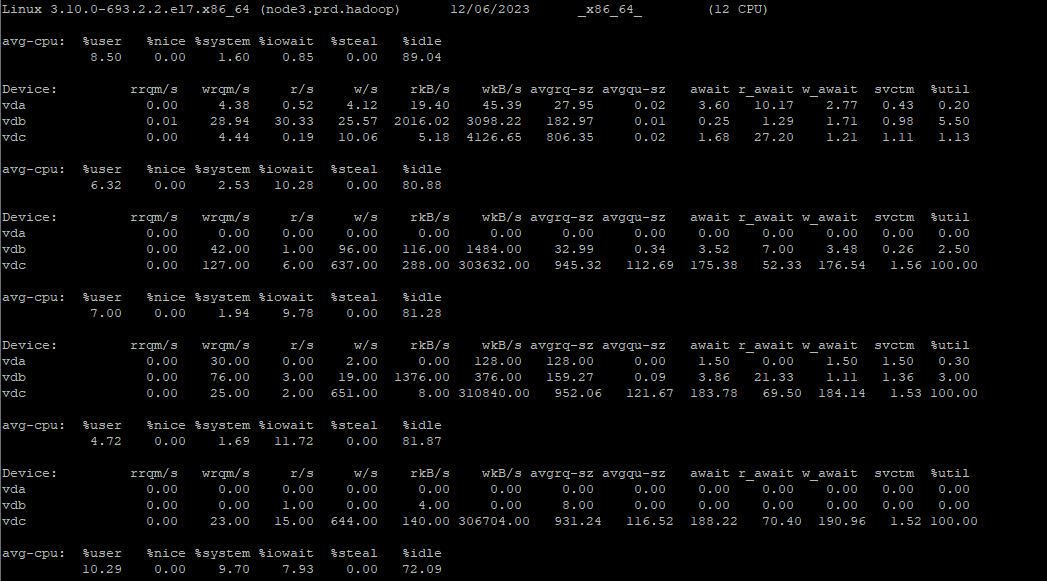

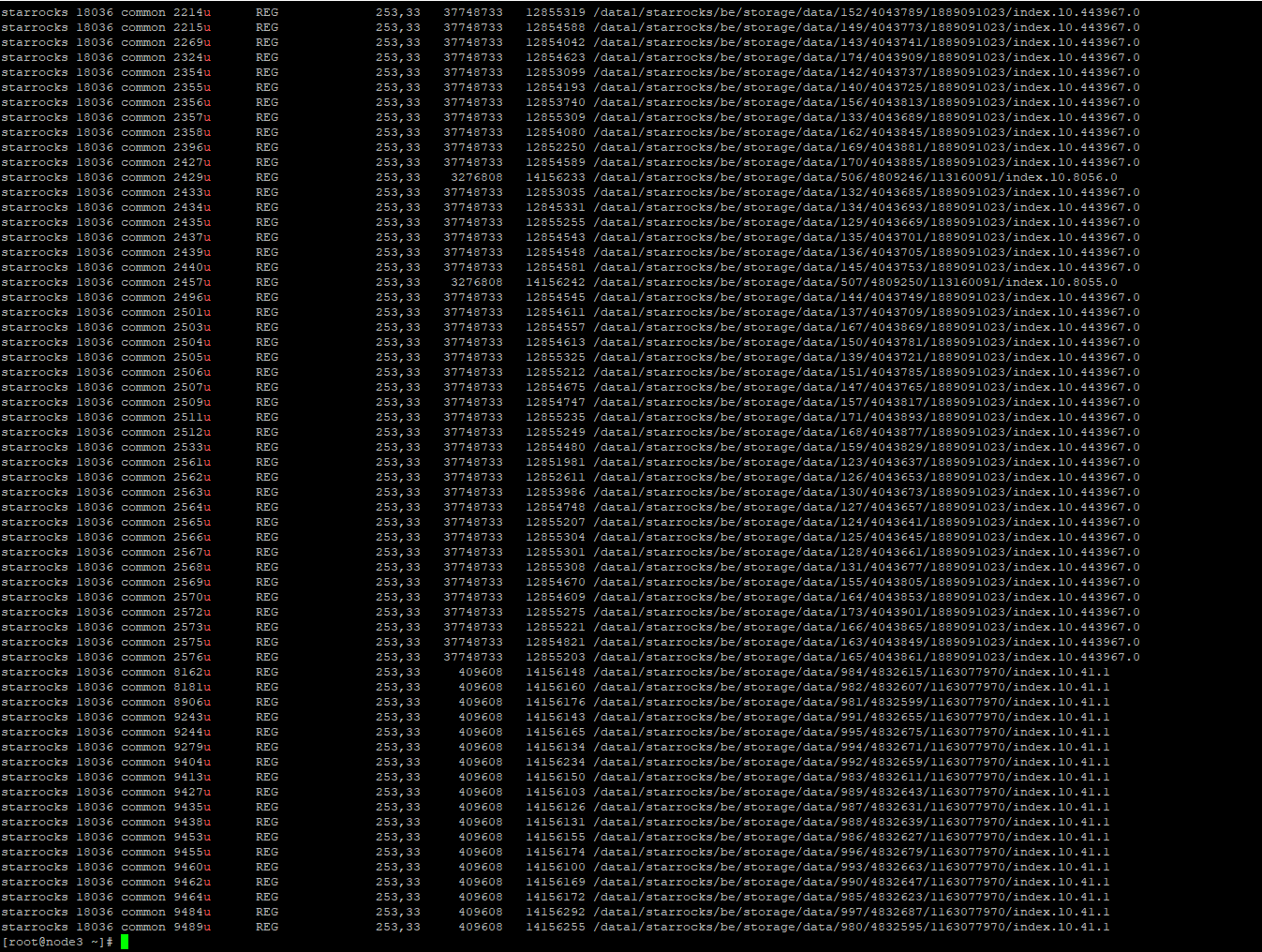

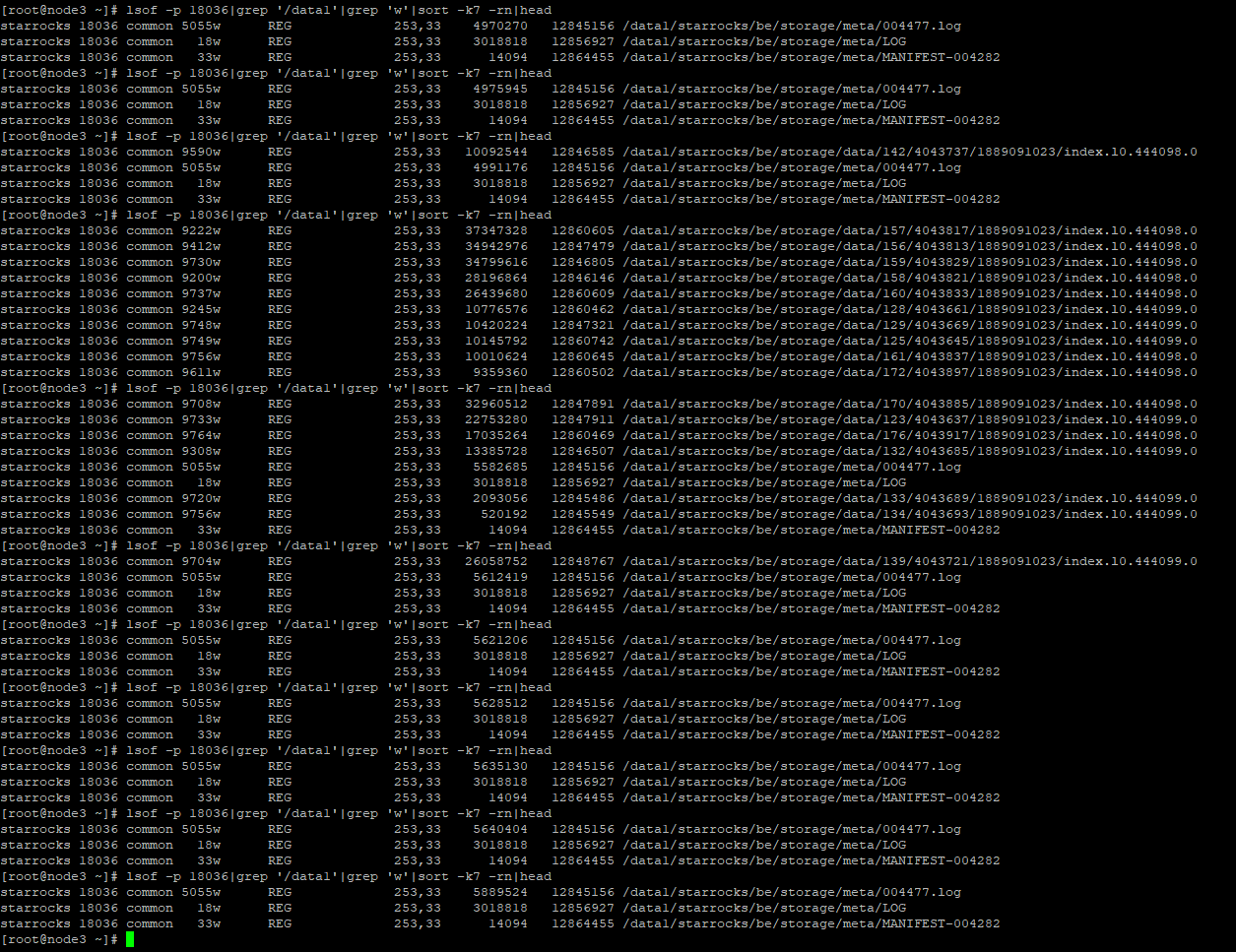

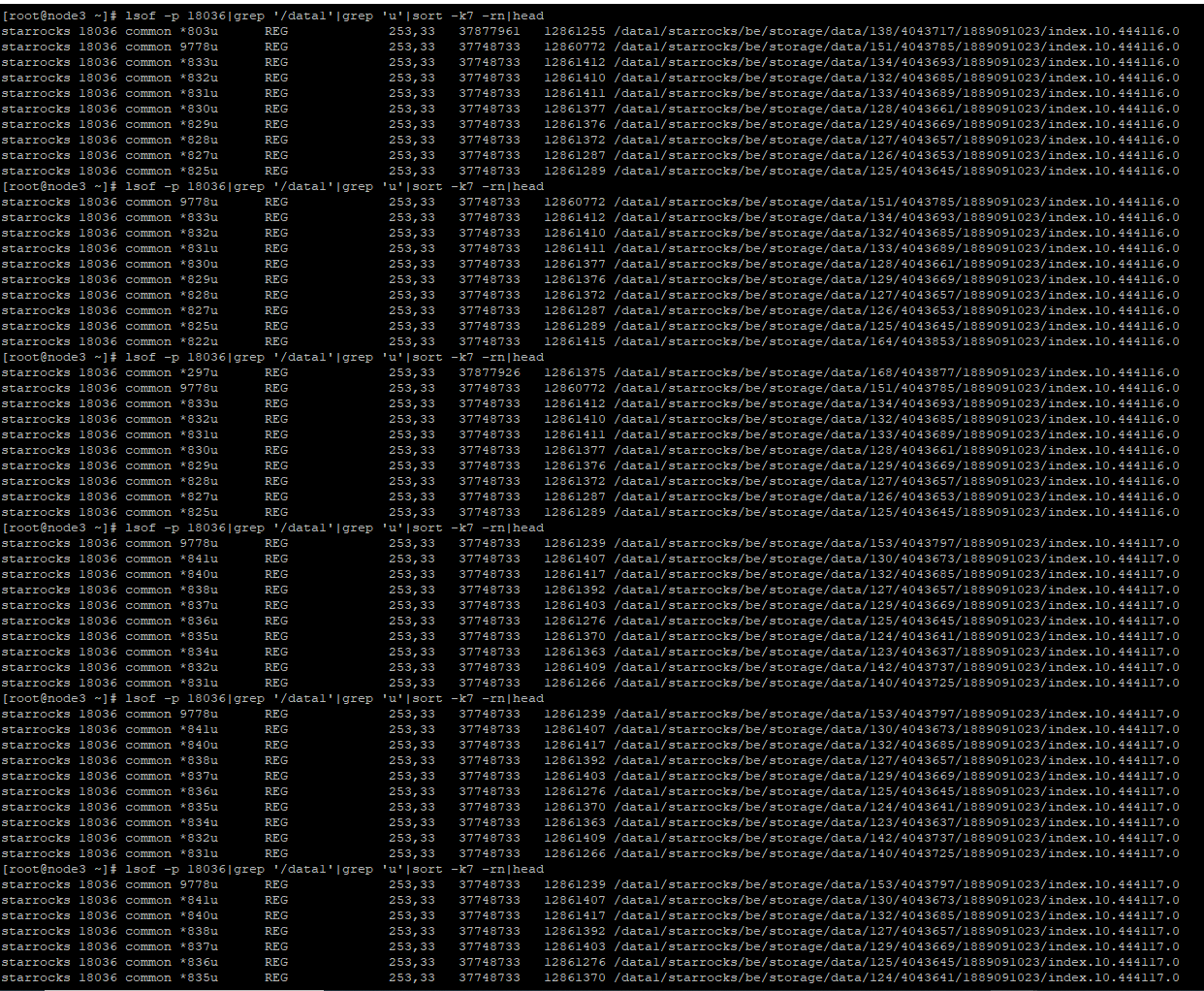

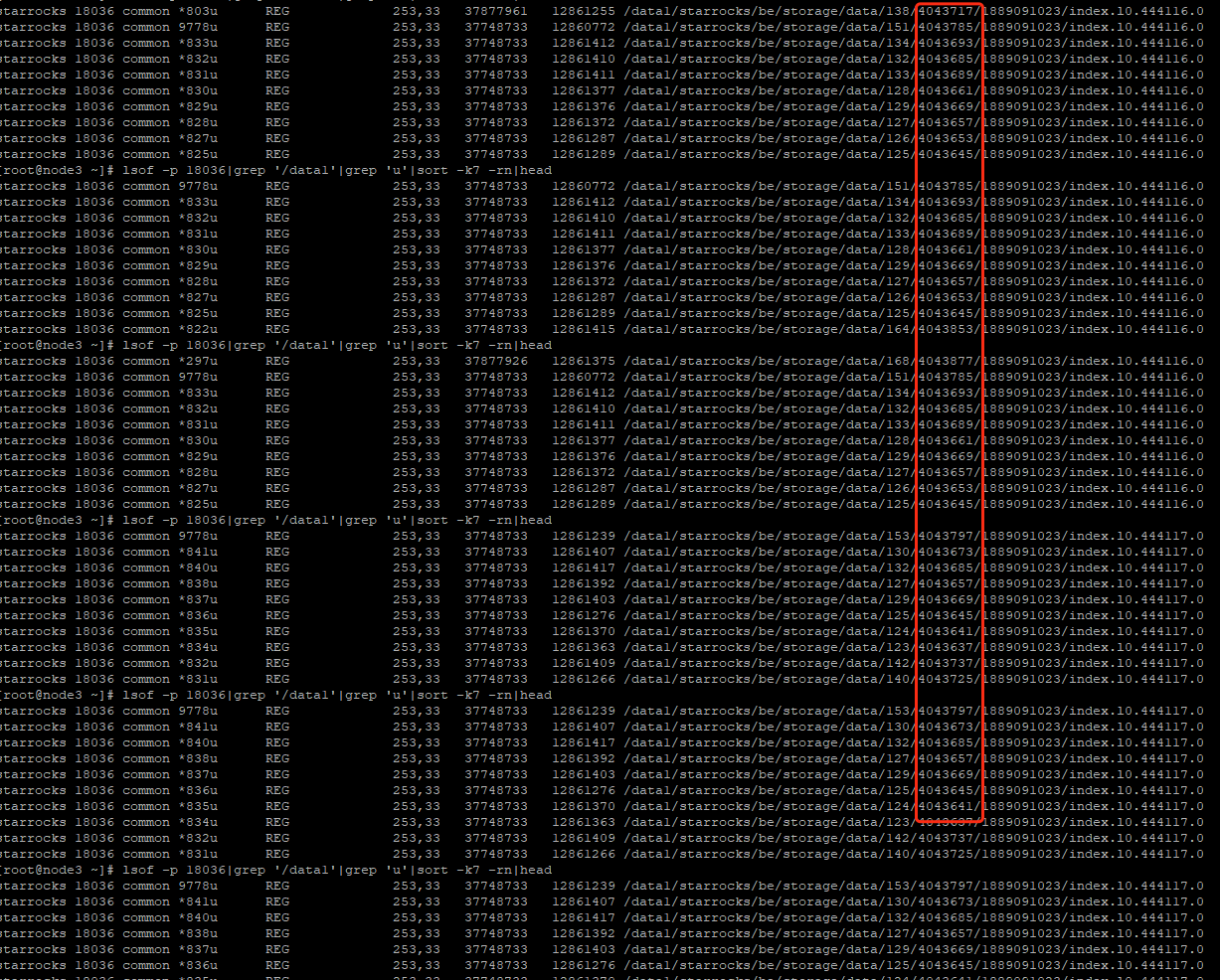

一台BE节点上iotop情况如下:

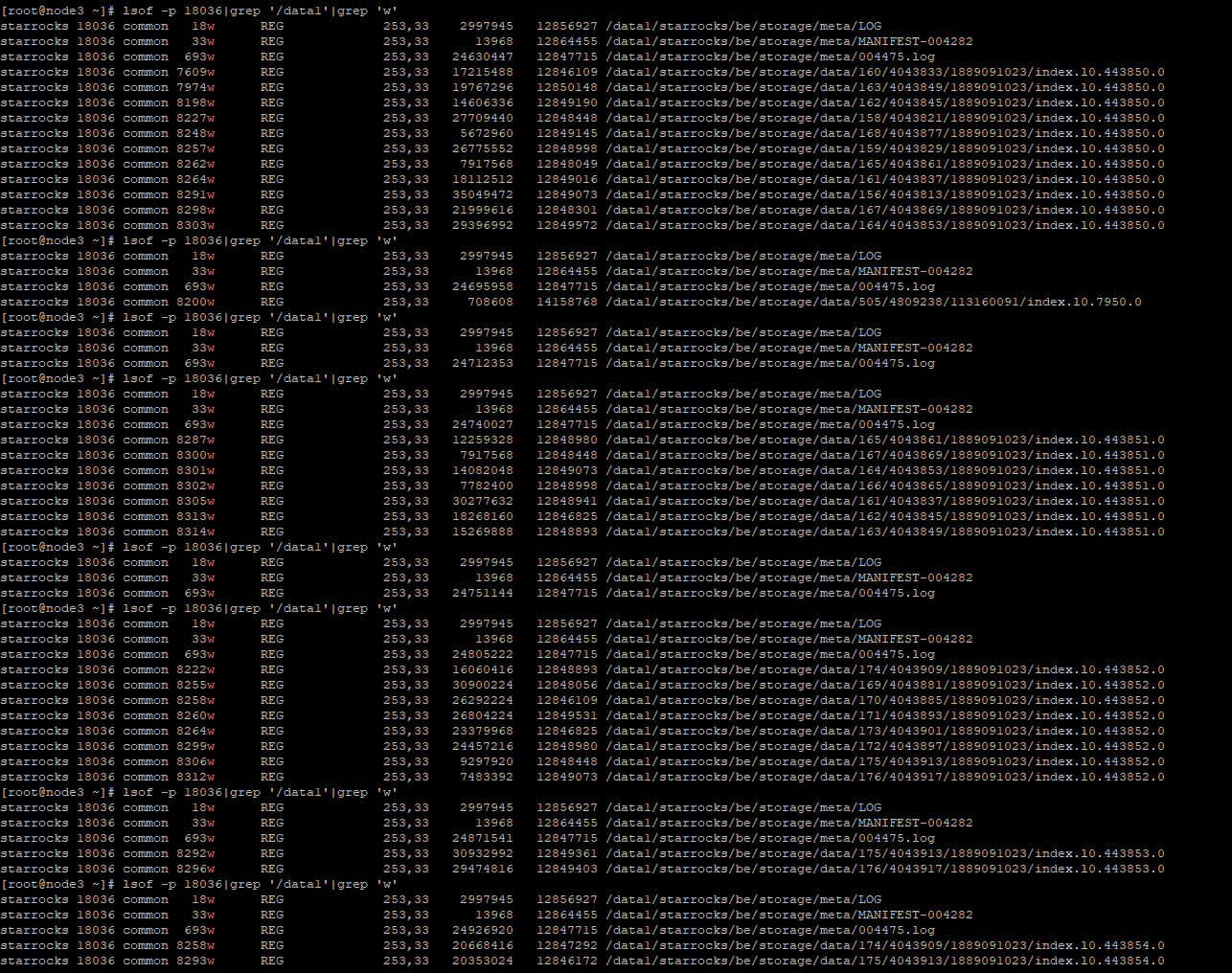

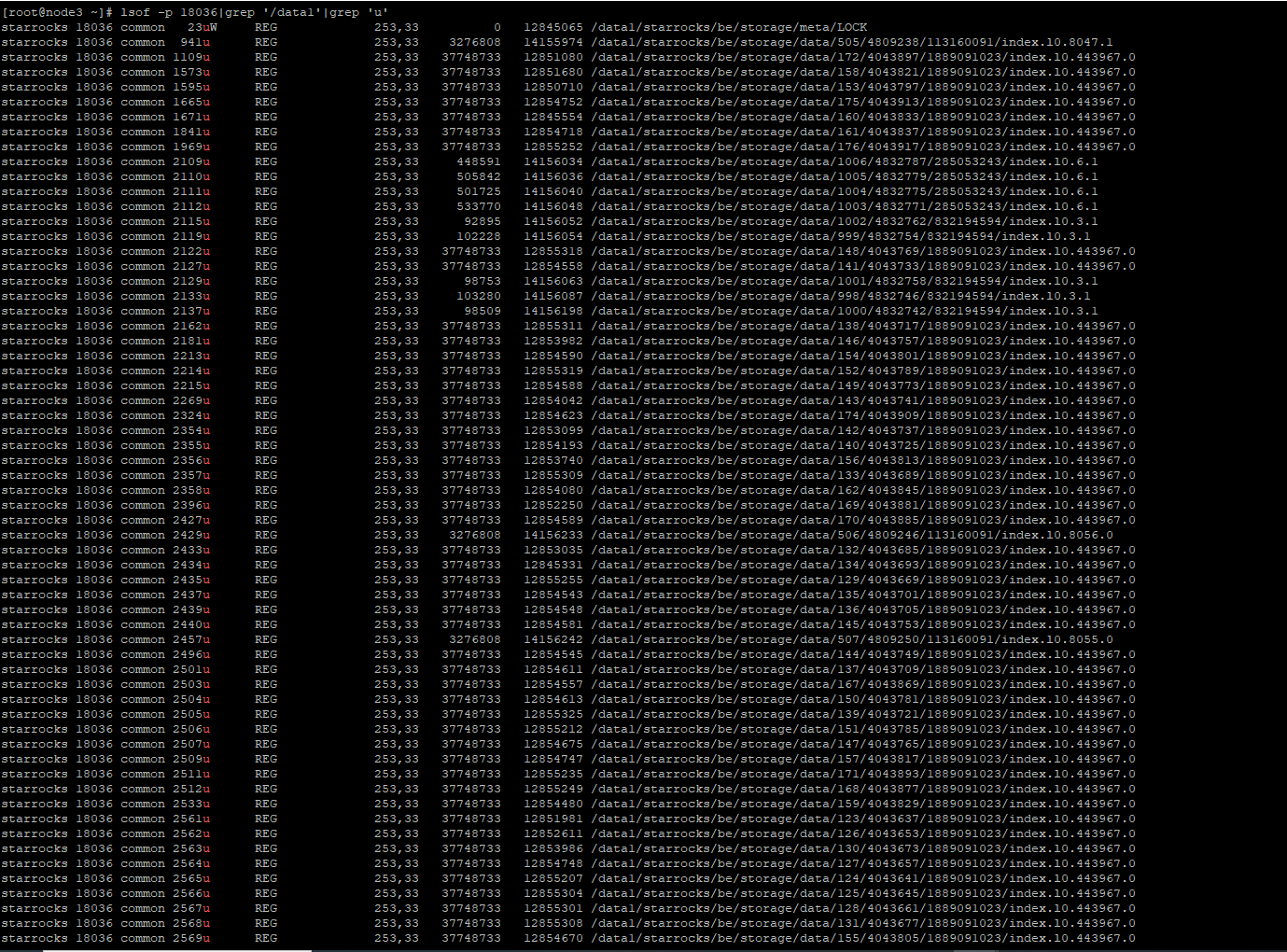

一台BE日志:

be.INFO_1205.tar.gz (45.6 MB)