为了更快的定位您的问题,请提供以下信息,谢谢

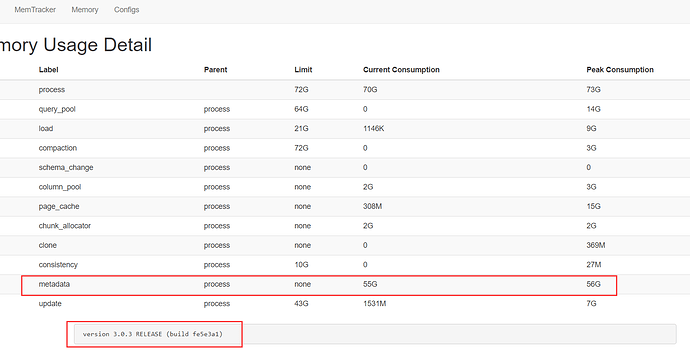

【详述】metadata占用了大量内存

【背景】flink导入大量数据

【业务影响】

【StarRocks版本】3.0.3

【集群规模】3fe+4be(fe与be混部)

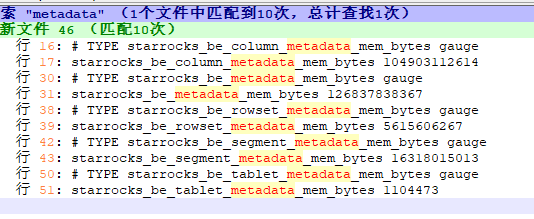

curl -XGET -s http://be_ip:8040/metrics | grep “^starrocks_be_.*_mem_bytes|^starrocks_be_tcmalloc_bytes_in_use”

看下是 metadata 中哪一项的内存占用高

您好,我这边也是遇到同样的问题:

机器是32U+256G的Be,超高IO(350M/s)

两张表:

第一张表75列,8亿行, avg_row_length 1836, tablet 分了218个

第二张表40列,46亿行,avg_row_length 1200, tablet 分了620个

第一张表导入完,第二张表表就会因为内存不足,Be就拒绝导入了;并且发现内存里面的数据基本不会减少

集群是哪个版本的

您好,我用的是单机部署 3.1.10版本

8亿行的表结构大概如下:

CREATE TABLE task_info (

id int(11) NOT NULL,

/**** 其余74行,有varchar和binint这些 ***/

) ENGINE=OLAP

PRIMARY KEY( id )

DISTRIBUTED BY HASH( id ) BUCKETS 218

PROPERTIES (

“replication_num” = “1”,

“in_memory” = “false”,

“enable_persistent_index” = “true”,

“replicated_storage” = “true”,

“compression” = “LZ4”

);

看下 第二张表报错时的内存统计信息,找到报错时的be日志,grep “Current memory statistics” be.INFO

您好,复现到那个场景需要很长一段时间,现在我们做了一些调整之后,规避了这个场景。关于这个问题的讨论,在下面这个帖子里面有更多的细节,希望对您有帮助:

column_metadata 内存居高不下 -  StarRocks 用户问答 / 日常运维 - StarRocks中文社区论坛 (mirrorship.cn)

StarRocks 用户问答 / 日常运维 - StarRocks中文社区论坛 (mirrorship.cn)