【详述】通过flink 创建hive catalog 并创建sr外表 insert into sr表 select * hive表

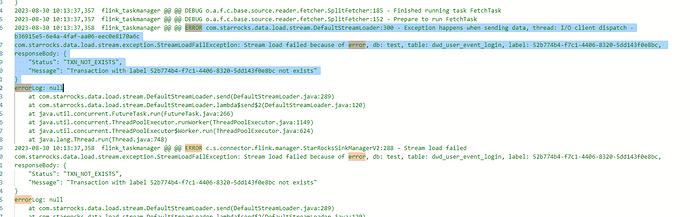

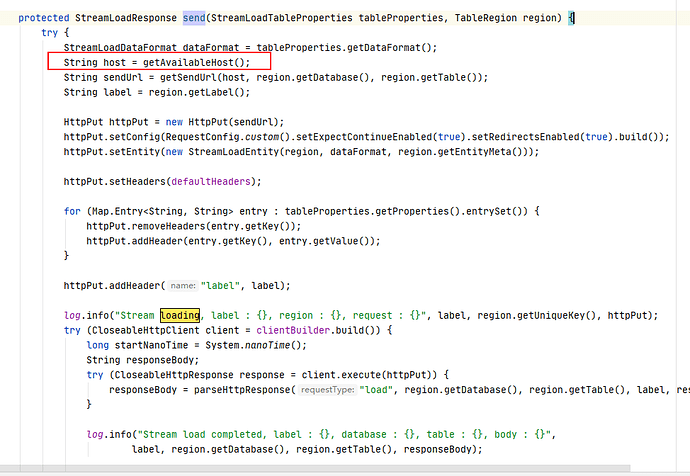

操作报错ERROR com.starrocks.data.load.stream.DefaultStreamLoader:300 - Exception happens when sending data, thread: I/O client dispatch - b36915e5-6e4a-4faf-aa06-eec0e8170a6c

com.starrocks.data.load.stream.exception.StreamLoadFailException: Stream load failed because of error, db: test, table: dwd_user_event_login, label: 52b774b4-f7c1-4406-8320-5dd143f0e8bc,

responseBody: {

“Status”: “TXN_NOT_EXISTS”,

“Message”: “Transaction with label 52b774b4-f7c1-4406-8320-5dd143f0e8bc not exists”

}

errorLog: null

【背景】hive表写入sr需求

【业务影响】 hive表无法写入sr

【StarRocks版本】3.0.4

【集群规模】3fe + 3be

【机器信息】36C/128G/千兆

【联系方式】社区群14伴梦

【附件】

flink报错:

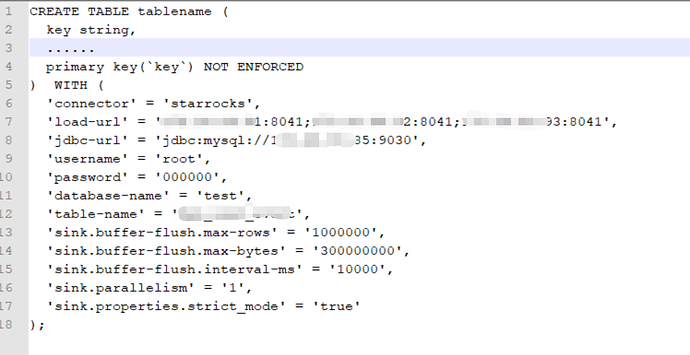

flink建sr表:

be_http_port是改过的就是8041