【StarRocks版本】3.0.0

【集群规模】3fe + 3be。 azure aks. 通过 starrocks-operator 部署

【详述】通过 spark-connector load data to StarRocks 失败。

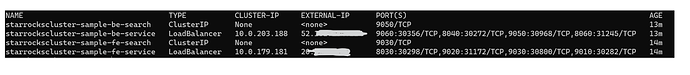

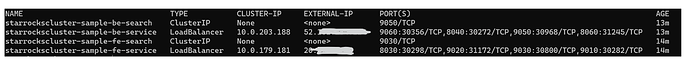

service: kubectl get svc -n starrocks

fe-service 和 be-service 开了 loadbalance.

在集群外部通过直连 be-service ip 可以通过 stream_load 能加载数据成功。

但是在尝试 spark-connector load data 的时候失败了。

按照文档 使用 Spark connector 导入数据(推荐) @ Spark-connector-starrocks @ StarRocks Docs

starrocks.fe.http.url 设置为 fe-service external ip 会报错如下,

是需要把 starrockscluster-sample-fe-search 也打开 external ip ?

也尝试了像 stream_load 那样直接在 spark-connector 访问 be service loadbalance 也不通,好像只能通过 FE ?

请问我这个问题要怎么解决呢?