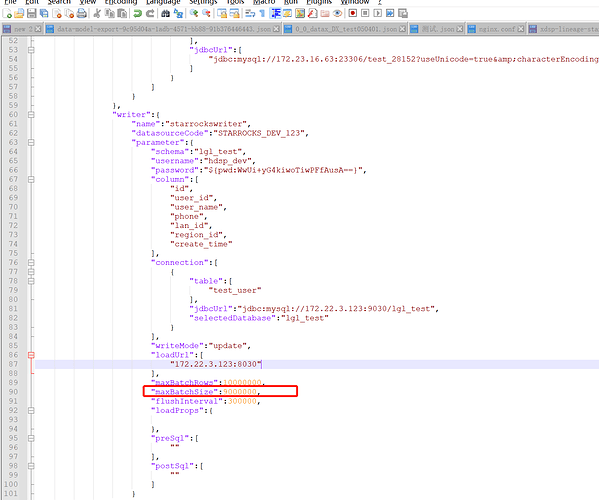

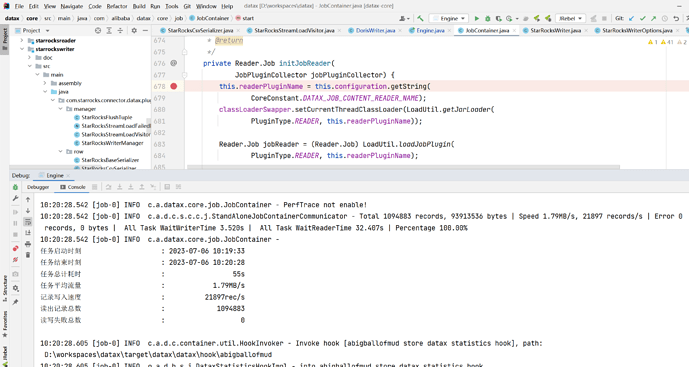

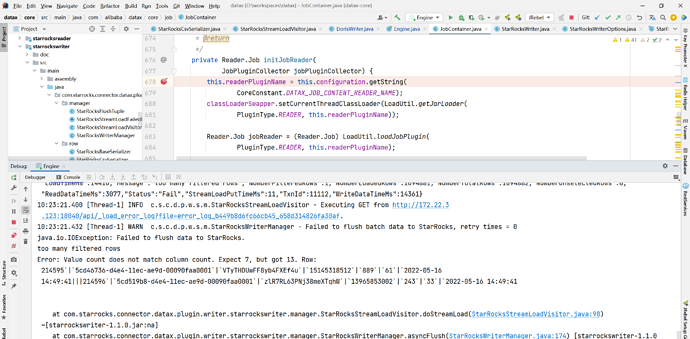

【详述】客户在使用datax进行数据同步时,先做了小数据量的测试,是可以正常同步的,但是换成3亿的大表发现报错,后面又拆成百万级别的表依旧报错,不断测试调整配置发现,只有在批次字节大小小于1000万时,可以正常同步,超过后,稳定报错复现。

【背景】

【业务影响】 无法正常同步,只能控制最大批次字节大小来保证任务运行,速度太慢

【StarRocks版本】例如:客户2.5,本地2.3.1

【集群规模】例如:本地1fe+1be

【机器信息】CPU虚拟核/内存/网卡,例如:48C/64G/万兆

【联系方式】768472457@qq.com

【附件】

如果超过就会报行分隔符识别问题