能看到吗 fe.log.20230327-1 (32.5 MB)

有什么解决办法嘛

发的不是对应时间的日志吧,unkown error会在对应fe中打印exception日志,发一个完整的日志

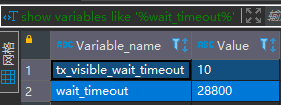

另外看下show variables like ‘%wait_timeout%’

是对应时间的日志 执行时间是3月27号18点半左右

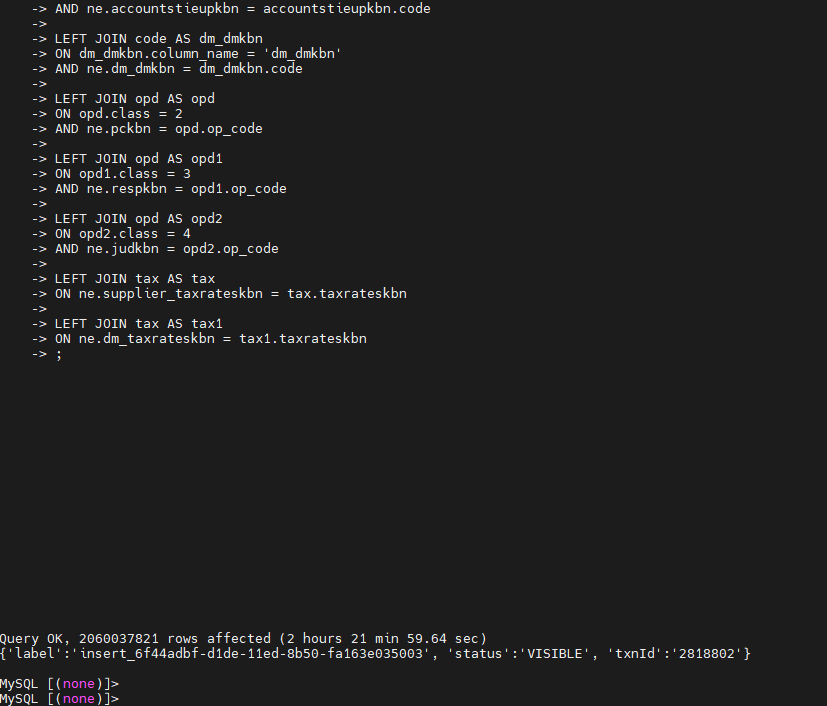

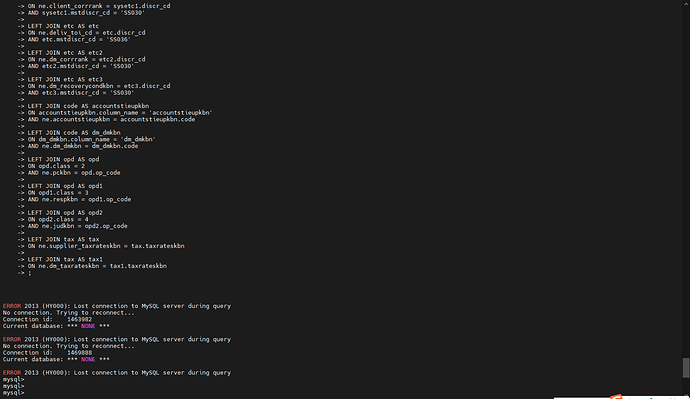

客户端好像可以正常执行了,但jdbc连接执行还是会出现300秒就报超时

1.show global variables like '%query_timeout%'确认下这个是300吗

2.确认下客户端或者中间代理层是否有配置空闲链接清理时间是300s的

这个问题原因是客户端或者服务端的空闲链接配置不一致,导致链接被清理了

这个确认了不是300,是已经修改的3600

客户端或中间件我再确认下

客户端或者中间代理层并没有配置空闲链接清理时间是300s

还是会报连接中断

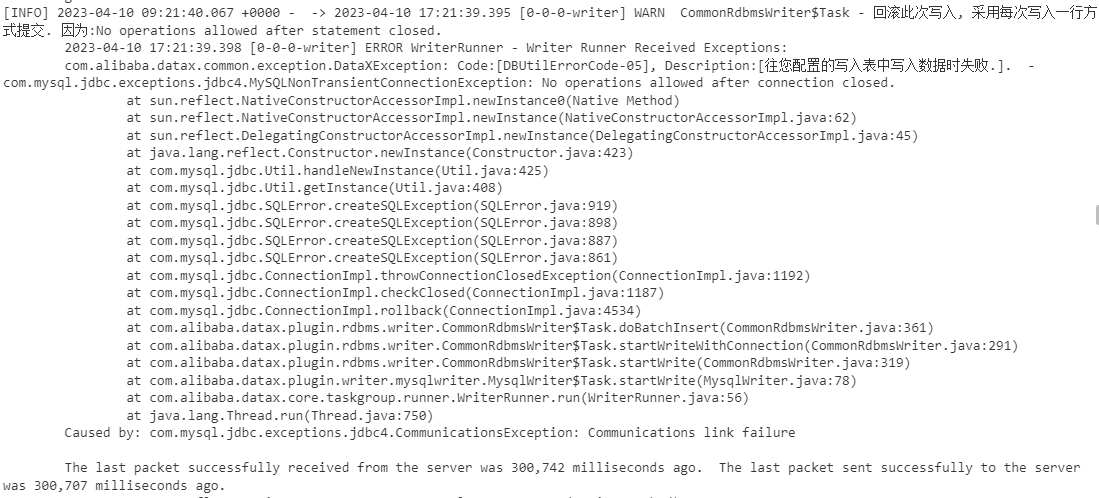

[ERROR] 2023-04-06 01:10:26.235 +0000 - execute sql error: Communications link failure

The last packet successfully received from the server was 300,090 milliseconds ago. The last packet sent successfully to the server was 300,091 milliseconds ago.

[ERROR] 2023-04-06 01:10:26.235 +0000 - sql task error

com.mysql.cj.jdbc.exceptions.CommunicationsException: Communications link failure

The last packet successfully received from the server was 300,090 milliseconds ago. The last packet sent successfully to the server was 300,091 milliseconds ago.

看着使用的datax?datax的任务配置发下

你的用法有问题,用starrockswriter,不要用mysqlwriter,具体参考 https://docs.starrocks.io/zh-cn/latest/loading/DataX-starrocks-writer

另外还有一个问题读pg的超时是不是300s,是的话就改大

嗯嗯,用streamload方式写入会快很多,但这个300s报超时和一开始的问题是不是一致的。读pg看了也不存在300s超时,感觉还是StarRocks 300s写入的问题