【详述】每天数据量200亿左右,经过过滤条件剩下真正导入的数据在20亿左右。kafka topic里分120个分区。建表一个分区分了64个桶

现在起了四个导入任务,每个任务设置13个task。每个任务消费一半分区。

感觉4个导入任务一共42个子任务去消费还是跟不上,是不是哪儿设置的有问题

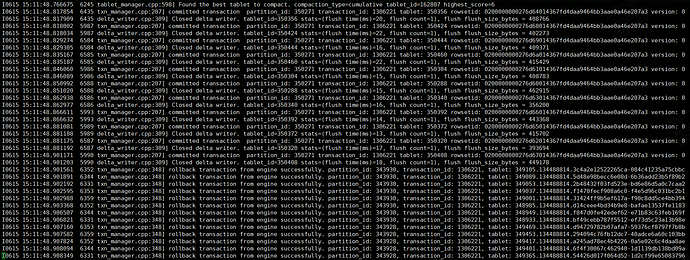

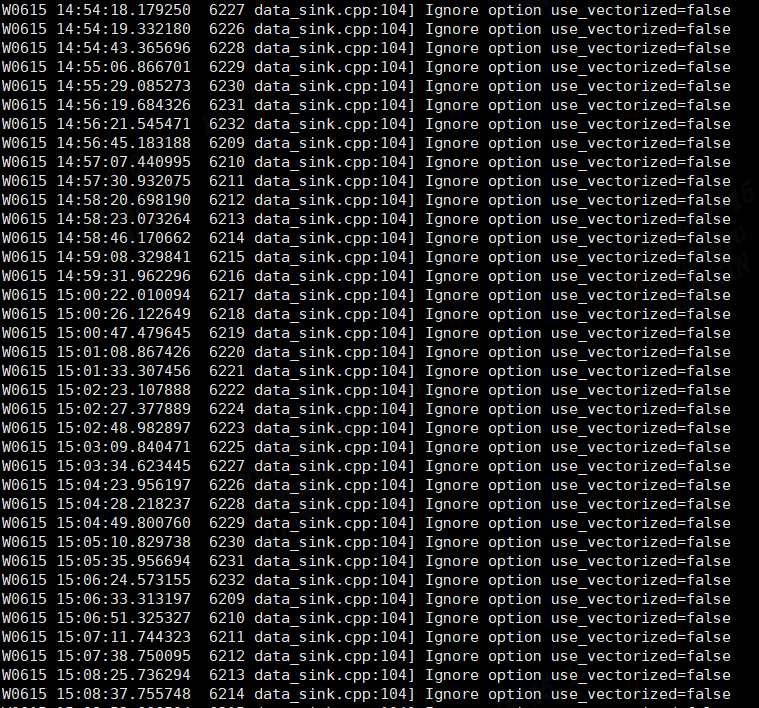

而且be.INFO一直打印

txn_manager.cpp:348] rollback transaction from engine successfully. partition_id: 343930, transaction_id: 1306037, tablet: 349105.134488814.3c4a2e12522265ca-084c41235a75cbb

这种日志

【导入/导出方式】 routine load 导入数据

【背景】配置routineload 导入一次消费时间2分钟

【业务影响】导入速率跟不上

【StarRocks版本】例如:2.1.1

【集群规模】例如:3fe(3 follower)+13be(fe与be混部)

【机器信息】40C/300G/万兆

【附件】