为了更快的定位您的问题,请提供以下信息,谢谢

【详述】问题详细描述

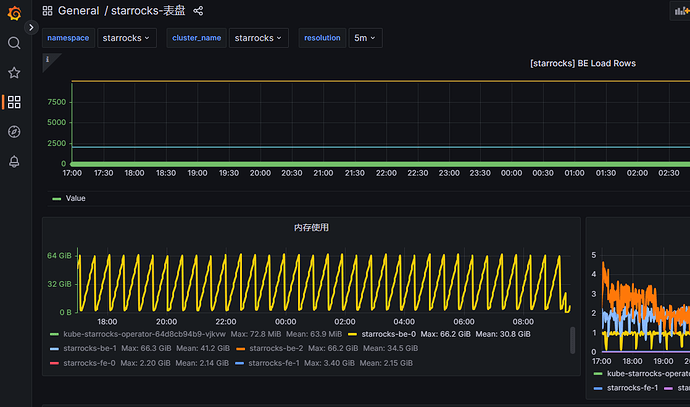

为表字段新增N-gram bloom filter 索引并显性设置case_sensitive = false,发现会相比与默认的case_sensitive = true使用更多的合并内存,最终会因为合并内存使用过大出现重试合并任务,合并任务一直出现循环性失败

【背景】做过哪些操作?

显性设置case_sensitive = false,合并内存会出现每个节点接近50g的合并内存占用

INDEX ginidx3_ntlmHostName (`ntlmHostName`) USING NGRAMBF("bloom_filter_fpp" = "0.05", "case_sensitive" = "false", "gram_num" = "4") COMMENT '',

INDEX ginidx3_ntlmDomainName (`ntlmDomainName`) USING NGRAMBF("bloom_filter_fpp" = "0.05", "case_sensitive" = "false", "gram_num" = "4") COMMENT '',

INDEX ginidx3_db2Cmd (`db2Cmd`) USING NGRAMBF("bloom_filter_fpp" = "0.05", "case_sensitive" = "false", "gram_num" = "4") COMMENT '',

INDEX ginidx3_db2Arg (`db2Arg`) USING NGRAMBF("bloom_filter_fpp" = "0.05", "case_sensitive" = "false", "gram_num" = "4") COMMENT '',

INDEX ginidx3_db2Response (`db2Response`) USING NGRAMBF("bloom_filter_fpp" = "0.05", "case_sensitive" = "false", "gram_num" = "4") COMMENT ''

如果将"case_sensitive" = "false"移除,合并内存占用基本低于6g每个节点

【业务影响】

compaction 内存占用过大,出现合并任务一直循环重试

【是否存算分离】

否

【StarRocks版本】

3.5.1

【集群规模】

3fe(1 follower+2observer)+3be(3个机器,每个机器均有1个fe与be混部)

【机器信息】CPU虚拟核/内存/网卡

fe k8s pod limit :10C/80G/万兆

be k8s pod limit :10C/80G/万兆

【联系方式】为了在解决问题过程中能及时联系到您获取一些日志信息,请补充下您的联系方式,例如:社区群4-小李或者邮箱,谢谢

社区群-28

【附件】

出现类似的内存占用