【详述】broker节点频繁报内存溢出然后挂掉

【背景】做过哪些操作?

【业务影响】brokerload导数失败

【是否存算分离】否

【StarRocks版本】3.0.5

【集群规模】例如:3fe +4be(fe与be混部)+4broker

【机器信息】72C/380G/万兆

【联系方式】阿坚

【附件】

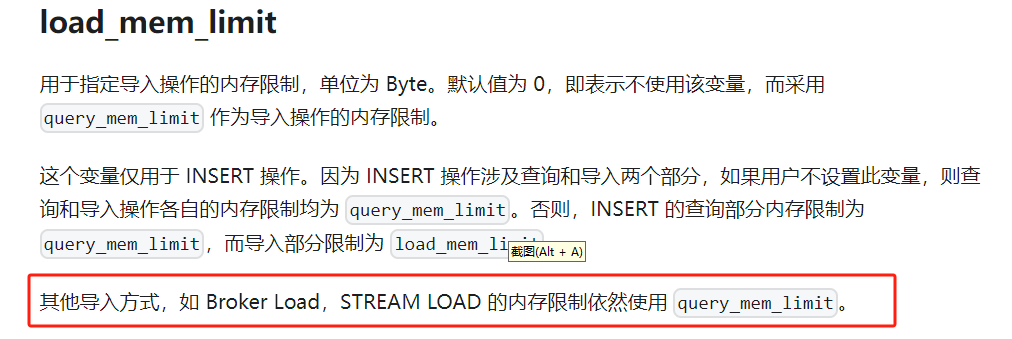

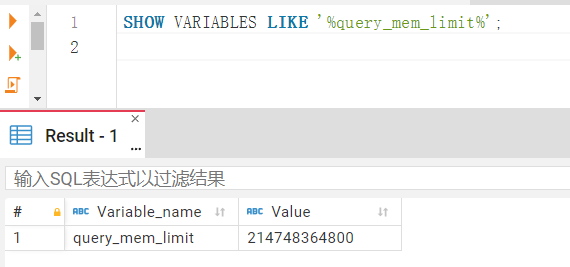

broker一共四个和be个数保持一致,内存也调整过,根据官方文档设置的query_mem_limit是200g,四台broker每台都200g内存根本不可能内存溢出啊,是不是参数设置的不对?

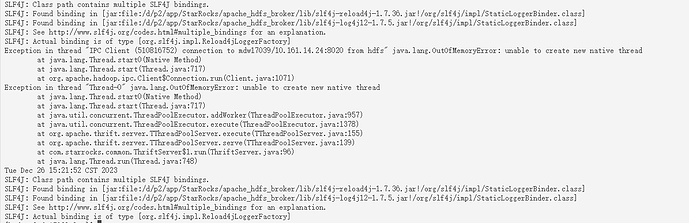

broker报错信息:

SLF4J: Class path contains multiple SLF4J bindings.

SLF4J: Found binding in [jar:file:/d/p2/app/StarRocks/apache_hdfs_broker/lib/slf4j-reload4j-1.7.36.jar!/org/slf4j/impl/StaticLoggerBinder.class]

SLF4J: Found binding in [jar:file:/d/p2/app/StarRocks/apache_hdfs_broker/lib/slf4j-log4j12-1.7.5.jar!/org/slf4j/impl/StaticLoggerBinder.class]

SLF4J: See http://www.slf4j.org/codes.html#multiple_bindings for an explanation.

SLF4J: Actual binding is of type [org.slf4j.impl.Reload4jLoggerFactory]

Exception in thread “Thread-0” java.lang.OutOfMemoryError: unable to create new native thread

at java.lang.Thread.start0(Native Method)

at java.lang.Thread.start(Thread.java:717)

at java.util.concurrent.ThreadPoolExecutor.addWorker(ThreadPoolExecutor.java:957)

at java.util.concurrent.ThreadPoolExecutor.execute(ThreadPoolExecutor.java:1378)

at org.apache.thrift.server.TThreadPoolServer.execute(TThreadPoolServer.java:155)

at org.apache.thrift.server.TThreadPoolServer.serve(TThreadPoolServer.java:139)

at com.starrocks.common.ThriftServer$1.run(ThriftServer.java:96)

at java.lang.Thread.run(Thread.java:748)